AI自我进化神器!Self-Refine让GPT-4输出飙升20%,无需训练即可搞定!

Self-Refine方法因其通过自我批评与反思显著提升大语言模型(LLM)输出质量,再度成为AI研究热点(https://arxiv.org/abs/2303.17651)。这一创新框架让单一LLM通过生成、反馈、优化的循环,自主迭代输出,无需额外训练或外部工具即可实现约20%的性能提升。AIbase观察到,Self-Refine对包括GPT-4在内的先进模型均有效,引发了开发者与研究者的广泛讨

Self-Refine方法因其通过自我批评与反思显著提升大语言模型(LLM)输出质量,再度成为AI研究热点(https://arxiv.org/abs/2303.17651)。这一创新框架让单一LLM通过生成、反馈、优化的循环,自主迭代输出,无需额外训练或外部工具即可实现约20%的性能提升。AIbase观察到,Self-Refine对包括GPT-4在内的先进模型均有效,引发了开发者与研究者的广泛讨论。

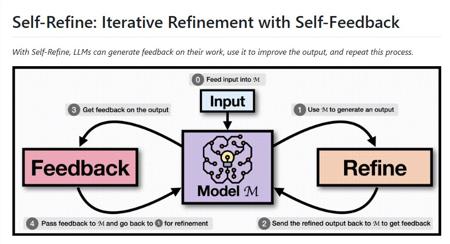

核心机制:三步循环实现自我优化

Self-Refine的核心在于一个自我循环提示法,通过单一LLM扮演三个角色实现输出优化:

生成初始回答:模型根据输入提示生成初步输出。

自我批评与反馈:模型评估自身输出,识别不足并提供具体改进建议。

基于反馈优化:利用反馈进一步完善输出,循环直至满足预设的“足够好”标准。

AIbase了解到,Self-Refine无需监督训练数据或强化学习,仅通过提示工程即可实现,极大地降低了应用门槛。测试表明,该方法在代码优化、对话生成、数学推理等七项任务中,平均提升约20%的表现,部分任务(如代码可读性)提升高达40%(https://selfrefine.info)。社交媒体反馈显示,开发者对其**简单性**和**通用性**尤为赞赏。

广泛应用:从代码到对话的全能提升

Self-Refine已在多种场景中展现出强大潜力:

代码优化:通过迭代改进代码结构与逻辑,GPT-4性能提升8.7个单位,代码可读性提升13.9个单位。

对话生成:初始对话输出仅25%受人类青睐,经Self-Refine优化后提升至75%。

文本生成:在情感分析与故事创作中,输出质量提升21.6个单位,文本更具逻辑性与吸引力。

AIbase编辑团队注意到,Self-Refine通过多维度反馈(如情感强度、逻辑清晰度)确保输出符合任务要求。例如,在生成宣传口号时,模型可通过反馈调整语气,使其更具感染力。开源代码(https://github.com/ag-ui-protocol/ag-ui)进一步降低了开发者的接入成本。

技术优势与局限:依赖基础模型能力

Self-Refine的独特优势在于其自给自足的设计:单一模型完成生成、反馈与优化,摆脱了对外部数据或工具的依赖。AIbase分析认为,这使其特别适合资源受限的场景,如边缘设备或独立开发环境。然而,社交媒体讨论指出,Self-Refine的性能高度依赖基础模型的能力,较弱的模型(如早期LLM)可能无法有效生成可操作反馈。此外,迭代过程可能引入延迟与计算成本,需权衡质量与效率。

行业背景:自我优化领域的竞争

Self-Refine的发布正值LLM自我优化技术蓬勃发展。CRITIC框架通过外部工具(如搜索引擎)增强自纠能力,而SELF方法则引入自主进化训练,允许模型生成训练数据。AIbase观察到,Self-Refine以其无训练需求和高通用性在竞争中占据一席之地,尤其受到初创公司与独立开发者的青睐。然而,内在自纠(仅依赖模型自身能力)的效果在复杂任务中仍有局限,未来可能需结合外部反馈进一步提升。

AI自我进化的起点

Self-Refine的成功标志着LLM从被动生成向主动优化的转型。AIbase编辑团队预计,未来Self-Refine可能扩展至多模态任务(如图像与语音生成),或通过与Chain-of-Thought等技术的结合提升复杂推理能力。然而,模型需克服反馈质量不均与迭代效率的挑战,尤其在实时应用场景中。开源社区的持续贡献(https://selfrefine.info)将推动其快速迭代与普及。

发表评论 取消回复