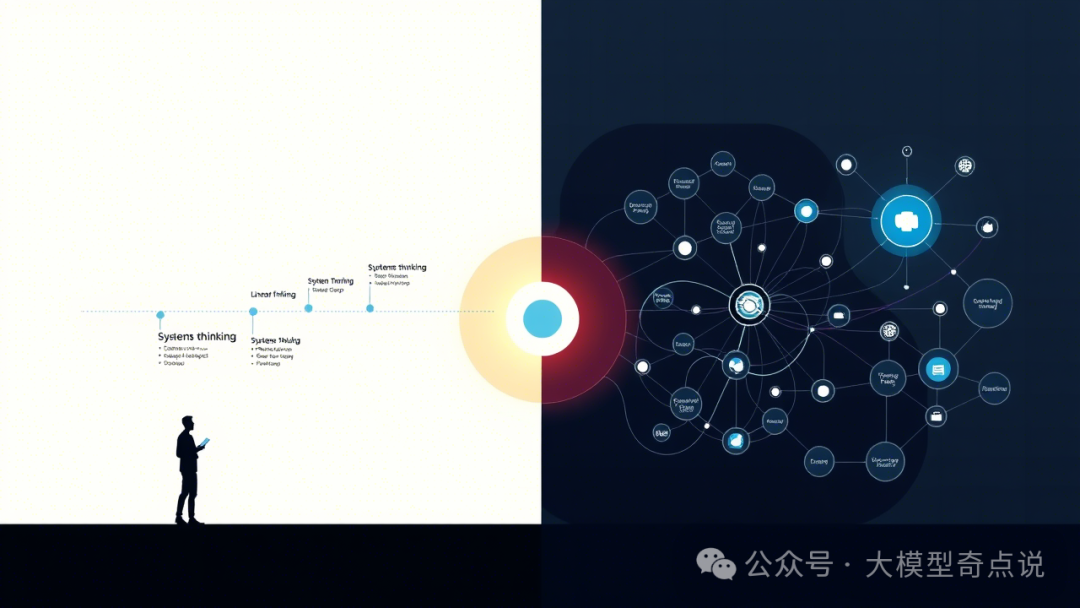

在AI时代,许多产品经理和设计师关注的是“如何提升模型”的能力:训练更大更强的模型、调优Prompt、提高答复质量……然而,用户真正体验到的永远是完整的产品系统,而不仅仅是背后的模型。正如研究者指出,如果我们只关心让AI模型“大脑”变得更聪明,就可能忽略其“身体”和“环境”这两大关键维度。系统思维(Systems Thinking)强调要从整体生态的视角来设计AI产品:数据流、业务流程、用户界面、反馈回路、组织协作和伦理约束等多重因素协同作用,才能让AI真正落地并获得信任。

为什么需要系统性思考AI产品

传统的AI产品设计往往局限于“模型设计”层面:开发更好的算法、调整Prompt、提升模型准确率。然而,在实际应用中,一个AI功能并非孤立存在,而是嵌入到复杂的业务和用户流程中。例如,一个客服AI机器人,即便回答语气再友好,如果没有与客户数据库系统打通、无法顺利转接人工客服、也不具备应对节假日高峰的扩容机制,那么用户体验依然会大打折扣。正如Qian Yang等人(2020)所指出的:“AI系统的准确度再高,如果无法无缝衔接后台流程和人工协同,用户体验依旧难以达标”。

更广泛地看,AI产品运行在现实世界的“花园”里:它们受到组织流程、法律法规、文化规范等多方面因素影响。例如,在医院里部署的医疗AI,不仅要给出诊断建议,还要考虑分诊优先级、报销账单规范、本地医疗文化等因素的影响,最终不同医院里同样的AI系统输出可能截然不同。这意味着,我们不能把AI当作脱离现实的黑盒来看待,而要承认它是一种**“生态现象”**:AI行为与其所处的社会、组织、物理环境紧密关联。MIT教授Ramy et al.(2019)也强调,只有将AI视为生态系统的一部分,我们才能全面理解其行为和影响。简单来说:终端用户体验到的永远是产品系统,而不仅仅是单个模型。如果只优化模型而不考虑整个系统,有可能在真实环境中埋下信任崩塌、伦理风险和运营故障的隐患。

AI产品的系统视角:核心要素

一个完整的AI产品系统通常包括以下几个核心要素:数据、用户体验、反馈机制、组织流程和伦理治理。只有从这些维度共同考虑,才能设计出可靠、可持续的AI系统。

- 数据体系

AI模型的表现高度依赖其数据基础。我们需要规划好数据采集、清洗、标注和更新的全流程,保证训练数据的多样性和代表性。比如大语言模型需要海量文本语料,而垂直领域的AI则要抓取特定用户群的行为数据。数据安全与隐私也是重点:ChatGPT在个人和企业版中对话记录采取了加密与严格隔离,避免敏感数据被滥用。像GitHub Copilot这样的AI编码助手,则训练于公开代码库,还加入了“可选代码引用过滤器”来检测并过滤匹配开源许可的代码片段,以防开发者误用已有代码。数据管道需要与产品各方协同:谁负责收集用户反馈、日志和行为数据?如何把这些数据反馈到模型更新?如果不考虑数据流的全链路,AI模型容易出现训练-上线-衰减的不闭环情况。 - 用户体验

AI是服务人的,设计时首先要站在用户角度思考。用户看到的可能是一个对话窗口、一个编辑插件或设计界面等,设计者需要考虑:这个界面传达出什么样的AI能力?如何让用户理解AI的操作逻辑与局限?例如,ChatGPT采用多轮对话界面,用户输入与AI回答形成串联反馈;Midjourney则通过Discord频道让用户在群体中观察和共同创造,强化了社群反馈。用户的信任感和掌控感也很重要——GitHub Copilot就是一个典型例子,它明确规定是可选功能,用户必须主动在编辑器中开启或关闭;它还提供了评论点赞的反馈机制,让用户参与到AI质量评价中。良好的AI用户体验设计不仅关注单次交互,还要关注体验全程:在用户第一次使用时如何引导、当AI出错时如何容错,以及长期使用后用户信任如何随时间建立等。这些都属于系统视角下的用户体验设计。 - 反馈回路

AI系统不是静态的,一旦上线就需要持续监控和迭代。设计良好的反馈回路,才能让模型不断改进,并及时修正偏差。比如在教育领域的AI评分工具中,如果只关注让模型判分准确,就可能忽视了学生反馈的机制:当学生对AI评判有异议时该如何处理?系统是否收集了学生对AI回答的纠正意见?随着不同批次学生的出现,AI会出现模型漂移和偏见风险,需要设计周期性评估、重新标注和再训练的流程。此外,也需要关注运营指标:某功能是靠“点击量”还是靠“用户满意度”来衡量?这些指标最终会影响模型更新的方向和频率。这种人—机—数据的闭环反馈,要求产品团队把数据科学、用户研究和工程部署串联起来,而不是单纯交给算法工程师去搞模型就了事。 - 组织结构

AI产品往往涉及多个角色:产品经理、设计师、数据科学家、后端开发、法律合规等。理想状态下,这些角色要跨职能协作,将系统思维植入到团队文化中。然而,现实中往往存在障碍:如Yang等(2023)指出,设计师经常发现自己难以直接影响算法决策,因为组织层面的分工限制了他们的权限。面对这种情况,有经验的设计师就会采取“界面触点倡导法”:即使他们只能做界面优化,也会记录用户遇到的系统性摩擦点,主动向团队说明这些问题反映的更大系统短板。例如,在开发一个问答式客服机器人时,设计师可以在原型评审时指出:**“当前AI的回复虽然正确,但用户无法看到客户信息历史,导致对话上下文不连贯。”**这种做法帮助团队意识到接口决策会影响到客户数据库和人工流程,从而推动组织层面作调整。总体而言,要实现系统设计需要高级别的跨部门协作;组织要为设计师和PM争取话语权,让他们参与技术选型和数据流程设计,而不是把他们局限在“美化页面”的框框里。 - 伦理与信任

AI产品的每一步都潜藏伦理风险:训练数据的偏见、自动决策的公平性、可解释性、合规性等都要纳入系统设计。实践中,很多团队将伦理审查框架内嵌到产品生命周期中,例如在模型训练阶段进行偏见检测,在上线前设置内容审查模块(ChatGPT有严格的内容过滤策略),或者在用户界面明确告知AI可能的不确定性。同时,政策合规、隐私保护也是系统化设计的重点。比如Figma在推出AI功能时明确表态:任何由Figma AI生成的内容都视为用户内容数据,用户保留对输出结果的权利。这种声明不仅解决了版权归属,也提升了用户对新功能的信任度。在中国语境下,还要考虑个人信息保护法、算法安全法等法规对产品的约束,将合规检查纳入研发流程。总之,只有把伦理审核、法律法规、社会影响等因素融入系统设计,才能构建可持续且安全的AI产品。

代表性案例:系统思维在AI产品中的应用

下面通过几个热门AI产品的实践案例,说明系统思维如何贯穿产品全流程。

- Notion AI

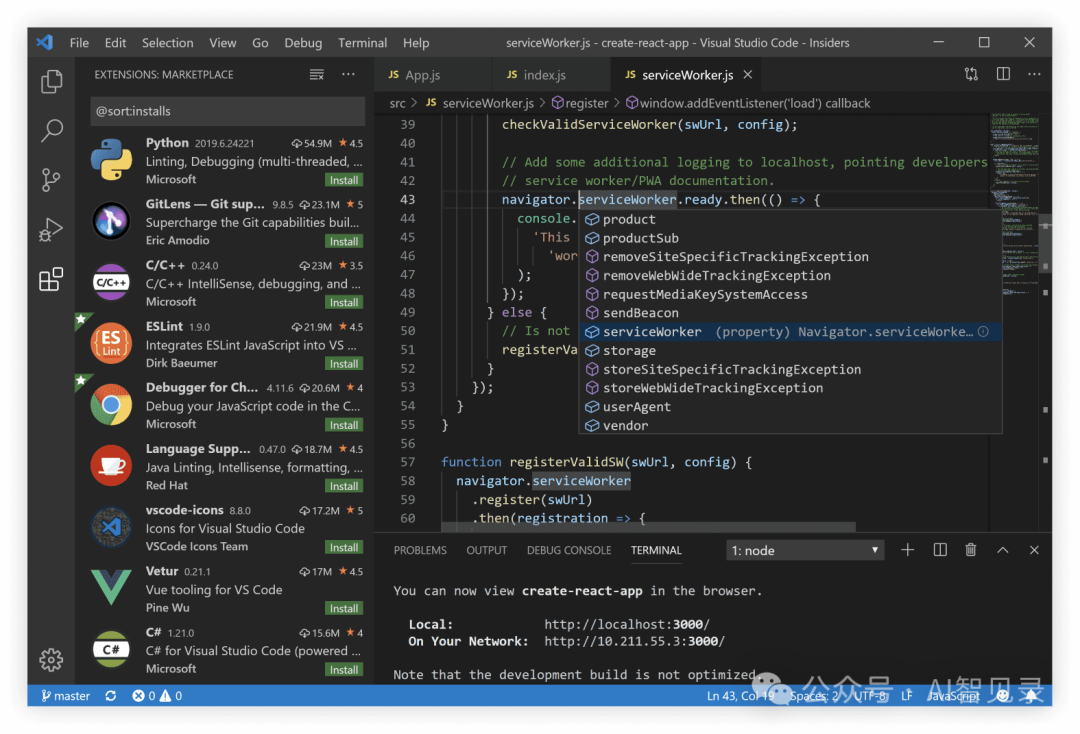

Notion的AI功能并不是简单地接入一个写作助手,而是整合到知识工作平台的整个生态里。Notion官方介绍称,Notion AI是一站式工具,集合了内容搜索、生成、分析和聊天功能。这意味着它可以从用户的所有Notion文档、Slack信息、Google Drive等渠道检索答案,然后以符合个人风格的方式生成或编辑文档,并结合GPT-4等大模型提供聊天咨询。在设计上,这要求系统能够自动获取和更新不同工具中的信息(数据整合)、提供统一的用户入口(界面设计)、以及明确告知用户哪些信息来自本地数据库、哪些来自外部大模型(透明度设计)。Notion AI的例子说明,真正的生产力工具AI是内嵌在工作流中的系统,而不仅是附加模型。 - GitHub Copilot

作为开发者的AI“协作者”,Copilot的成功很大程度上得益于它的系统集成设计。Copilot并非一个独立的网站,而是无缝嵌入在VS Code、Visual Studio、JetBrains等常用IDE中的插件。它背后的AI模型来自GitHub/OpenAI(Codex系列),并且训练于海量公开代码数据。在系统层面,Copilot允许用户随时开启或关闭这项功能,根据项目类型选择启用语言,并提供点赞/点踩等反馈按钮让用户参与模型改进。此外,GitHub还为企业版Copilot增加了“代码引用”审核功能,当建议的代码与公开许可证冲突时会发出警告。这些设计体现了Copilot团队的系统思维:他们处理了安全(开源许可)、信任(用户控制)、数据(Git仓库语料)、反馈(用户评价)等多种要素,使Copilot不仅仅是一个“智能补全”模型,而是一个负责提示、审核、反馈和迭代的端到端开发者工具。 - ChatGPT

OpenAI的ChatGPT凭借对话模式改变了人们对AI的认知。其系统设计包括:多轮对话界面(用户输入-模型回应-追问-再回应),上下文记忆机制,以及大量的人类反馈训练环。用户可以通过连续提问不断“训练”ChatGPT理解对话背景(这其实是个隐式反馈回路),同时可以通过点赞、举报等动作让系统收集对回答质量的反馈。OpenAI还逐步开放了插件功能,让ChatGPT可以调用外部搜索和应用API,这需要后台支持外部数据源访问和安全审查。在实际使用中,ChatGPT结合了产品化的细节:用户注册体系、使用量限制、企业隐私模式等。这些都超越了基础模型本身,属于完整产品系统的范畴。 - Midjourney

Midjourney是一款流行的图像生成AI,其产品设计非常强调用户互动与社区参与。用户通过Discord频道提交文本提示,Midjourney机器人返回多张生成图像,用户再选择“放大”“变体”或重新提示,这个交互本身就是一个迭代设计闭环。这个流程中,人机之间的反馈循环非常明显:模型建议→用户筛选→继续提示,结合了人类审美的实时反馈。Midjourney团队还实时监控生成内容,加入内容过滤器来避免暴力或成人内容(伦理考量)。从运营角度,Midjourney是订阅制服务,需要处理服务器负载、用户并发等工程问题;在数据层面,它不断收集用户的有效提示和选择,优化后续版本的生成质量。这些都体现出Midjourney的系统思维:它不仅是一个图像扩散模型,而是一个完整的“创意协作平台”,包含社交、产品和技术层面的系统设计。 - Figma AI

作为设计师的生产力工具,Figma引入AI功能也走的是系统集成路线。Figma官方博客指出,Figma AI是一系列功能,旨在帮助设计师“更高效、更有创造力地工作”。具体来说,Figma将视觉搜索、语义搜索等AI功能嵌入到界面中:设计师可以上传图片或截图来搜索团队已有的组件(Visual Search),或用自然语言检索按钮、图标等设计元素(Asset Search)。这些功能背后的系统设计要点包括:需要分析团队库里的所有设计文件(大规模数据检索)、理解视觉语义(AI算法)、并在界面上友好地展示结果(UI设计)。值得注意的是,Figma明确规定,“任何由Figma AI生成的内容都被视为用户内容,用户保留对输出结果的使用权”,这消除了设计师对版权和隐私的后顾之忧,提升了AI功能的可用性。通过这些设计,Figma AI并不是独立的模型演示,而是嵌入到日常设计流程中的AI助手。

系统思维的实践指南

面对庞大的系统设计任务,设计师、产品经理和工程师可以遵循以下策略来落地系统思维:

- 从“第一性原理”思考AI设计

回到问题的本质,质疑现状和假设。我们应问:到底谁需要这项自动化功能?会产生什么价值或风险?比如在设计AI评分系统前,应先明确:其核心目的是替代老师打分,还是协助老师发现盲点?充分考虑不同用户(专家、普通用户、学生)对AI透明度的不同需求。利用第一性原理的思路,可以避免陷入“只靠现有模型输出”的窠臼,而是重新审视问题框架。 - 绘制AI系统可视化图

用简单的流程图或架构图,把AI产品的边界、数据流、模块和外部系统标注出来。图示中要明确:哪些数据输入到AI模型?哪些结果由前端展示?哪里有人工监控?哪些环节可能产生误差?将这些可视化图交给团队和利益相关者,共同讨论各环节职责和风险。这样的图示能够揭示模型可控区域以外的因素(如第三方数据源)、不确定区域(如模型随机性)等,有助于大家对AI系统有统一的认识,提前设立人机协作的检查点。 - 关注时间演化(Temporal design)

AI产品不是一成不变的工具,而是随着使用不断学习和适应的系统。设计师需要思考:随着时间推移,AI如何更新用户偏好?界面如何反馈模型“学习”的进展,而不会让用户感觉“怪异”?用户与AI交互越久,他们对AI能力的期望和信任会发生变化,这需要在产品中预留“成长曲线”设计。例如,初期可能要给用户更多解释说明,而当AI表现稳定后,可以逐步简化提示界面;用户熟悉后再引入高级功能。时间设计鼓励我们为AI系统的不同阶段设计不同策略,而不是将产品当作静态软件看待。

通过以上原则,我们从根本上把系统视为“设计对象”而不仅是模型本身。正如Claudia Canales在文章中所说:“用户体验的是系统的质量,而不仅仅是模型的能力”。我们要设计的不仅是界面和Prompt,而是人机交互的关系和环境。只有这样,才能让AI产品在真实世界中持续服务人类需求,而不是沦为“好看的白板”或“吹起来的大气球”。

结语:构建人与AI共生的未来

AI产品设计正在经历从“单点模型优化”到“端到端系统建设”的转型。产品经理、工程师和设计师需要携手,将系统思维贯穿于从需求分析、数据准备、模型开发到上线运营的每一个环节。前路虽远,但机遇巨大:当我们真正以系统视角来审视AI产品时,就能发现更多创新点和安全边界,将智能的潜力转化为可持续的产品价值。让我们不再只是“AI模型的操作者”,而成为驱动AI与人类协同进化的系统设计师。

发表评论 取消回复