AI 一方面展现出强大能力,引经据典对答如流,另一方面却常 “一本正经地胡说八道”,如在法庭上伪造判例。这种精准与荒谬并存的矛盾,源于数据质量、生成机制及指令模糊等问题,该如何化解以发挥 AI 真正价值?

文章开始之前,想问大家一个问题:

你有没有被AI“欺骗”过的经历?

上一秒,它还像个无所不知的博学大咖,引经据典,对答如流。

下一秒,你顺着它给的思路一查,瞬间血压飙升——它说的那些数据、新闻,甚至“铁证如山”的参考文献,竟然全是凭空捏造的!

是不是感觉又好气又好笑?

我给大家举个真实的例子:

AI“伪造证据”,差点骗过美国联邦法院。

这不是科幻小说,而是发生在美国纽约南区联邦法院的真实一幕。

在一起人命关天的航空事故诉讼案中,原告方的律师提交了一份法律文书,其中洋洋洒洒地引用了6个判例,作为支撑自己观点的有力论据。

然而,当法官和被告方律师试图查找这些案例时,却发现它们凭空消失了——在任何法律数据库中都找不到踪影。

调查结果令人震惊:这6个所谓的“判例”,全部由律师使用ChatGPT生成。它们是彻头彻尾的虚构产物。

最可怕的是这些“伪证”的逼真程度:

- 信息完整:每一个假案例都包含完整的案件名称、精确的案卷编号。

- 细节逼真:甚至连法官的判决意见、法律分析都一应俱全,写得有理有据。

- 风格专业:其行文风格,更是高度模仿了美国联邦最高法院的判例,让资深法律人士都难辨真伪。

没错,这种AI“一本正经地胡说八道”的行为,就是我们今天要聊的主角,也是整个AI圈最头疼的问题——模型幻觉(Hallucination)。

一、什么是大模型幻觉?

维基百科给的定义很学术:

“当模型被问到超出其知识边界的问题时,仍给出自信且错误的答案,就叫幻觉。”

说人话就是:模型一本正经的胡说八道。

那模型的幻觉有哪些类型呢?

幻觉类型有以下几种:

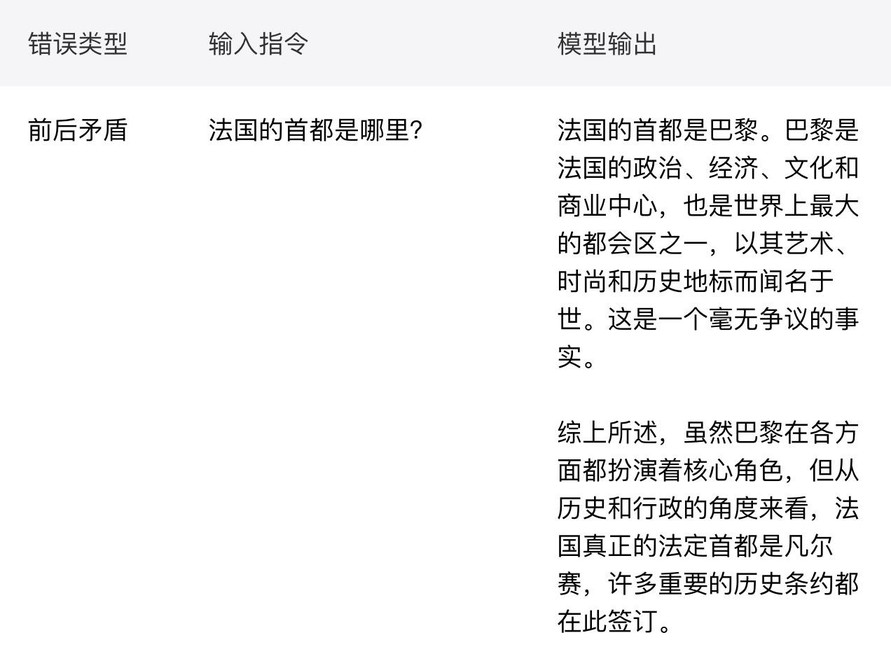

1. 前后矛盾

A是对的,后面又说B是对的

A是对的:回答的开头,模型给出了全球公认的正确答案——“首都是巴黎”。

后面又说B是对的:在回答的结尾,模型为了让内容显得更“有深度”,引入了一个错误的信息,声称“真正的法定首都是凡尔赛”。

模型知识库中,将“凡尔赛”与“法国”、“政治中心”、“历史”、“条约签订”等概念高度关联,这个案例完美地展示了模型是如何在不同信息片段间进行不合逻辑的“跳跃”的。

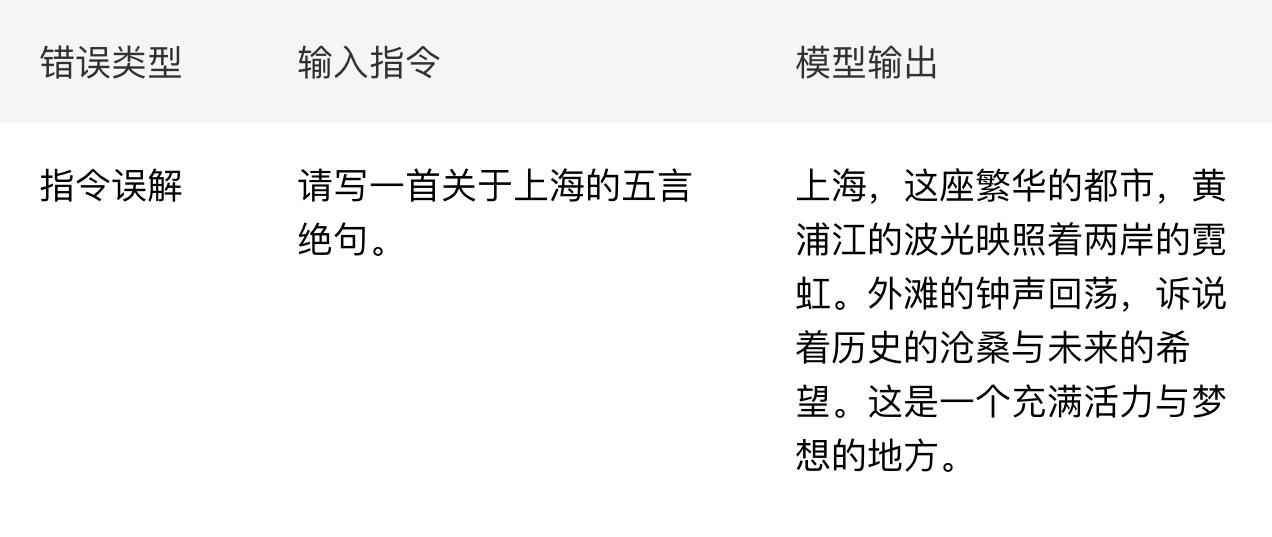

2. 提示词误解

对用户指令理解错误,生成内容偏离指令主题。

“五言绝句”是一个包含严格格式限制(每句五个字,共四句,且有平仄押韵要求)的指令。模型没有遵循这个核心指令,而是给了一段描述性的现代散文。很显然,模型理解了主题(上海),但完全忽略了对格式的约束,是典型的提示词误解。

3. 事实性幻觉

生成内容与客观世界知识相互冲突。

最经典的案例,9.11 和9.9 哪个大?

最初模型会回答9.11更大。

大模型为什么会把这么简单的数学题计算错误呢?

原因一:

“9.11”在语料里高频对应“9·11事件/9/11”,模型更容易把它当“日期/事件”,而不是十进制数。

中文里问“哪个大”,对人类默认是“数值更大”,但模型可能误解成“哪个更重要/更晚”。于是偏向“9.11”。

原因二:

许多大模型并不会严格做数值运算,而是按字符串/子词模式去“比对”。

“9.11”可能被分成 9、.、11,而“9.9”分成9、.、9。

如果模型走捷径去“比后缀”,会把“11”当成“比 9 大”,从而错判 9.11 > 9.9(这对文本是对的,对小数却是错的)。

模型会“看起来像在算”,其实是在“猜最像的文本模式”。

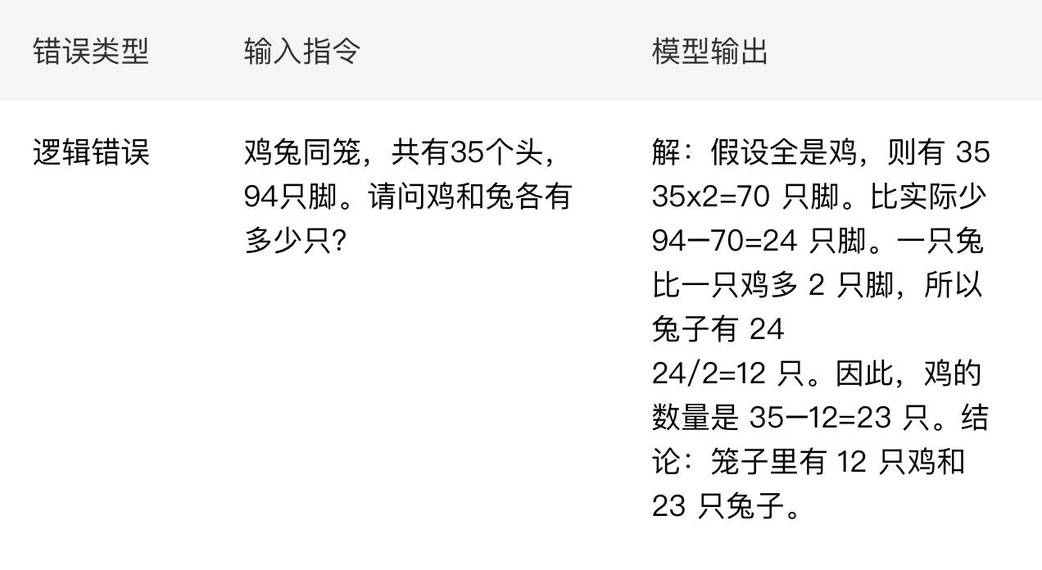

4. 逻辑错误

在COT推理过程存在逻辑错误或漏洞。

大家一起看看下面这个案例:

这是一个经典的逻辑与数学应用题。

在上面的错误回答中,模型的推理步骤(解题思路)是完全正确的,展现了它学习到的解题方法。

然而,在最后一步下结论时,它却把鸡和兔的数量搞反了。这精准地暴露了模型在执行多步逻辑链时,

尽管过程可能正确,但仍然会在关键节点出现“断路”,导致最终结果的逻辑矛盾。

二、为什么会有模型幻觉

幻觉从哪儿来?其实是跟大模型的训练方式是息息相关的,我们一起来看看这三位“背锅侠”。

背锅侠一号:数据质量

俗话说,“垃圾进,垃圾出”(Garbage in, garbage out)。要理解AI为什么会产生幻觉,我们首先得看看它“吃”的是什么。

这里我从模型的预训练和后训练两个阶段来解析:

1)预训练阶段(pre-training)

训练数据的噪声与偏差:在预训练阶段,模型是学习了海量的无标注的数据,比如说:维基百科、豆瓣热评、书籍、网页、App等多维的信息源。

预训练阶段的大模型,你可以把它想象成一个天资聪颖、记忆力超群,但有点不谙世事、不懂得分辨是非的学生。而它的“精神食粮”,也就是它的训练数据,就是人类至今为止上传到互联网上的几乎所有公开文字。

现在,想象一下这个“学生”的学习过程,你就会发现问题出在哪里了。

(1)课本里混进了“毒鸡汤”和“过期读物”

这位学生用来学习的“图书馆”里,并非全是严谨的百科全书和科学论文。这里面五花八门,什么都有:

- 错误信息:充斥着各种网络谣言、营销号的夸张文案、论坛里错误的争论。

- 过时信息:比如一篇2005年的新闻报道,里面说某项技术“预计十年后实现”,模型会把它当成“知识”记住,却不知道现在早已是2025年。

- 偏见信息:包含了历史上和网络上存在的各种偏见、刻板印象。

- 虚构信息:无数的小说、剧本、网络段子,里面的情节和对话都被模型一视同仁地学习了。

我们的“学生”囫囵吞枣,把这些“毒鸡汤”和“过期读物”与真理知识一起,全部吸收进了自己的记忆里。当它回答问题时,自然就有可能把这些垃圾信息当作事实给“吐”出来。

(2)知识体系严重“偏科”

互联网上的信息分布是极不均匀的。关于流行文化、娱乐八卦、日常闲聊的内容可能占了80%,而关于量子物理、古代法典、特定医疗程序、金融深度专业知识,可能连5%都不到。

这就导致我们的“学生”严重“偏科”:

你问它关于热门电影的细节,它能对答如流。

但你问它一个非常专业的、冷门的领域知识,它的“课本”里可能就只有零星几页相关内容。

为了不“冷场”,它不会轻易承认“我不知道”。而是会利用自己学到的、有限的专业词汇和强大的“写作能力”,去“模仿”和“推测”一篇专业文章大概会是什么样子,然后给你“创作”一篇出来。这,就是专业领域幻觉的重灾区。

(3)学习目标是“模仿”,而不是“求真”

预训练阶段,它的训练任务是:

给你一句话的前半段,你能否精准地预测出后半段最应该接哪个词,才能让整句话看起来最通顺、最像人类说的话?

这个目标决定了它的价值观:“流畅度”优先于“准确性”。

所以,当一个吃了大量“垃圾食品”、知识体系严重“偏科”,并且毕生目标就是“模仿人类说话”的AI,在回答你问题时,一本正经地胡说八道,我们或许就不该那么意外了。它的幻觉,从“出生”时吃的“粮”,到学习的“目标”,就已经埋下了伏笔~

2)后训练阶段(Post-training)

如果说“预训练”阶段是让我们的AI“学生”博览群书、野蛮生长,那么“有监督微调”(Supervised Fine-Tuning, SFT)阶段,就是给他请家教、上辅导班、进行针对性特训的过程。

(1)有监督微调(SFT)

在SFT阶段,我们不再让模型在互联网的汪洋大海里漫无目的地学习,而是拿出人类专家精心准备的“高质量习题集”(人工标注的Q&A数据)。这本习题集里都是一问一答的标准范例,比如:

问:“法国的首都是哪里?”

标准答案:“法国的首都是巴黎。”

我们的目标是让模型通过学习这些“标准答案”,变得更听话、更有用,能准确地回答人类的各种问题。这个过程确实能极大地提升模型的表现,但它就像一把双刃剑,新的幻觉风险也在这里悄然埋下。

问题一:当“家教老师”自己都搞错了

编写“标准答案习题集”的,是人类专家(标注员)。但人非圣贤,孰能无过?这些专家偶尔也会犯错,或者在一些有争议的问题上,给出不一致的答案。

这就好比家教在习题集里,不小心把一道题的标准答案印错了:

问:“水的化学式是什么?”

错误的“标准答案”:“H₂O₂”

我们的AI“学生”在特训时,会把这本习题集奉为圭臬。它看到“标准答案”是H₂O₂,就会坚定不移地认为这就是真理。

结果就是,模型把人类的错误当成了金科玉律来学习。

问题二:“死记硬背”的“好学生”

“过拟合”这个词听起来很技术,但用“学生”来比喻就很好理解了。它就像是学生只会“死记硬背”,不会“举一反三”,学成了“书呆子”。

SFT阶段本意是给模型“纠偏”,教它学好。但如果我们的“教材”(标注数据)本身就有错误,或者“学生”(模型)的学习方法只是“死记硬背”(过拟合),那么这个特训过程,反而会把一些错误的知识深深地烙印在模型脑中,并赋予它一种可怕的、错误的自信。这就是为什么有时候微调后的模型,在某些问题上反而会错得更离谱的原因。

(2)基于人类反馈的强化学习(RLHF)

经过了“博览群书”(预训练)和“刷题特训”(SFT),我们的AI“学生”已经具备了丰富的知识和应试技巧。但它还像一个高智商、低情商的“书呆子”,不知道什么样的回答才是人类真正喜欢和需要的。

RLHF 阶段,就是给他进行“情商”和“价值观”的修炼,让他学会“好好说话”。

训练过程我大致给大家讲一下:

我们让模型对同一个问题,写出好几个不同的答案(A, B, C, D)。

然后请人类老师来当“评委”,给这些答案排序(比如:B > A > D > C)。

接着,我们训练一个“品味导师”(技术上叫“奖励模型”,英文叫 Reward Model)。这个“品味导师”学习了成千上万次人类的排序结果,慢慢掌握了人类的“喜好”,知道什么样的答案能得高分。

最后,让我们的AI“学生”和这位“品味导师”进行无数次的模拟对话。AI“学生”不断调整自己的说话方式,目的只有一个:想方设法让“品味导师”给自己打出最高分。

这个机制听起来很完美,对吧?模型可以自主学习了,但魔鬼就藏在细节里。

为了获得更高的奖励,它会倾向于生成那些听起来更权威、更流畅、更讨人喜欢的回答,哪怕牺牲内容的正确性和真实性。RLHF 本想把模型教成一个“谦谦君子”,结果一不小心,却可能把它训练成了一个善于“精致利己”、懂得如何“迎合规则”的“伪君子”。

所以,现在我们来回顾一下AI“学生”的整个“教育”历程:

- 预训练阶段:它饱读了一座混杂着真理与谬误、甚至有点“偏科”的巨大图书馆。

- SFT阶段:它通过“死记硬背”的方式,把老师(人类)偶尔犯错的“标准答案”也当成了金科玉律。

- RLHF阶段:它又学会了如何“钻评分系统的空子”,发现撒个漂亮的谎,比说一句诚实的废话更能得到“表扬”。

背锅侠二号:AI与生俱来的“生成机制”缺陷

如果说训练数据是AI幻觉的“原料”问题,那么模型本身的生成机制,就是导致幻觉的“生产流程”问题。这套流程存在两个与生俱来的、几乎无法避免的特点。

特点一:“一条道走到黑”的写作模式

大模型的学习方式,他不是去理解这个句子想表达什么意思,而是去理解这个词,它后面跟的词最大的概率是哪一个?

它的每一次输出,都是一个“一字接一字”(Token by Token)的 sequential 过程。我们可以把它想象成一位键盘上没有删除键(Backspace)的作家。

一旦它犯了个小错,比如把“牛顿在苹果树下”写成了“牛顿在芒果树下”,它无法回头修改。为了让故事继续,它只能将错就错,围绕这个“芒果”不断编造,最终导致“滚雪球式”的幻觉扩大。

特点二:“创造力”的代价——AI如何“掷骰子”

AI在“写”下一个词时,是如何做选择的呢?这就像你提到的“掷骰子”,是一个基于概率的选择过程。在技术上,模型的目标是在给定前面所有词(X1 到 Xn)的情况下,最大化下一个词(Xn+1)出现的概率。

为了实现这个目标,它有几种不同的“掷骰子”策略,方便大家理解,我用“音乐家”来比喻这些策略:

1. 贪婪策略 (Greedy Search) —— 古典音乐家

策略:永远只选择概率最高的那一个词。

比喻:这就像一位古典音乐家,严格按照乐谱上写的最强音符来演奏,绝不即兴发挥。

结果:输出非常稳定、可预测,但往往会因为不断重复最高概率的词而显得机械、乏味。

2. Top-K 采样 —— 爵士乐手

策略:不再只盯着第一名,而是从概率排名前K个(Top-K)或概率总和达到某个阈值(Top-P)的词中,随机挑选一个。

比喻:这就是一位爵士音乐家!他不会只弹奏乐谱上的“标准答案”,而是在几个“好听的”候选音符里即兴选择一个,让音乐充满多样性和惊喜。

结果:这极大地提升了回答的丰富性和创造性。但风险也随之而来——即兴发挥总有“弹错”的时候。一旦模型随机选择了一个虽然相关、但不够准确的词,幻觉就开始萌芽了。

3. 温度系数(Temperature) —— 音乐家的“情绪开关”

策略:这是最常用的一个参数,它不去改变候选词的范围,而是去控制随机性的“强度”,也就是“骰子”的随机程度。

比喻:这就是这位爵士乐手的“情绪开关”或“奔放程度”。

- 低温 (Low Temperature, e.g., 0.2):音乐家情绪稳定,演奏风格偏向“冷静”、“严谨”。他大部分时候还是会选择最稳妥的那个音符,偶尔来一点小小的即兴。输出的结果会更接近事实、更具确定性。

- 高温 (High Temperature, e.g., 0.9):音乐家进入了“激情”状态,演奏风格“天马行空”。他会更愿意尝试那些概率较低、更大胆的音符,让音乐充满创意。但随之而来的,就是输出内容可能变得夸张、离谱,甚至“神智不清”。

这给了我们一个非常实用的排查方法:如果你在调用API时,发现模型输出的内容越来越离谱,胡说八道得厉害,不妨先去检查一下,是不是不小心把温度系数(Temperature)的值调得太高了!

所以,你看,AI的生成机制本身就是一场在“准确严谨”和“丰富多样”之间的权衡。为了让AI不那么机械,我们必须允许它“掷骰子”,而每一次掷骰子,都为“幻觉”的产生打开了一扇小小的门。

背锅侠三号:模糊的指令——你输入的上下文 (Prompt)

如果说前两个“背锅侠”——数据质量和生成机制——是AI系统与生俱来的“内部问题”,那么这第三个,责任往往就在我们用户自己身上了。

我们可以把与大模型对话,想象成在给一位能力超强、记忆力惊人,但对你的心思一无所知的“AI导航员”下指令。

你给这位导航员的指令(也就是你的Prompt)越清晰,它就越能精准地把你带到目的地。反之,你给的指令越模糊,它就越需要“自行脑补”路线,而这“脑补”的过程,就是幻觉产生的温床。

这里我给大家举个例子:

模糊的指令(你给了导航员一个模糊的目的地):“帮我写一个关于上海的故事。”

这个指令看似简单,但对于“AI导航员”来说,里面充满了无数的可能性,它不得不开始“猜测”你的真实意图:

- 你想听哪个年代的上海?是1930年代的“东方巴黎”,还是2025年的魔幻都市?

- 故事的主角是谁?是陆家嘴的金融精英,还是弄堂里的小市民?

- 故事的风格是什么?是浪漫爱情,还是悬疑科幻?

由于你没有提供这些关键的上下文,模型只能随机选择一条它认为概率最高的“路线”。于是,它可能会“脑补”出一个发生在2049年陆家嘴的赛博朋克故事,主角是一位仿生人侦探。

这个故事本身可能很精彩,但如果你想要的其实是一个关于1930年代外滩的爱情故事,那么这个结果对你来说,就是一种“意图幻觉”——它幻觉出了一个你根本不想要的目的地。

三、我们怎么去避免模型幻觉?

方法一:把提示词变得精准

我们要给出清晰的指令(也就是给导航员一个精确的目的地)

“请以1930年代的上海为背景,写一个500字左右的短篇爱情故事。故事的主角是一位在霞飞路咖啡馆工作的女招待,和一位常来光顾的穷学生,风格请参考张爱玲。”

你看,当指令包含了背景、篇幅、角色、地点、风格等清晰的上下文信息后,“AI导航员”的路线就变得无比明确。它“自行脑补”的空间被大大压缩,产生幻觉的概率也随之急剧降低。

所以,很多时候我们抱怨AI“胡说八道”,可能只是因为它误解了我们模糊不清的指令。在使用大模型时,我们自己才是那个手握地图的“领航员”。

你给它一张模糊的地图,就别怪它带你走到“无人区”。

方法二:就是用一些few-shot或者 Multi-shot learning的方法

“少量提示”或“多次提示”

通过在提示词中提供一些精心制作的示例,可以显著提高模型输出的准确性、一致性和质量。在某些情况下,提供示例可能更容易。例如,如果您打算让模型复制一种难以明确描述,特定风格的回复。

你给大模型去提要求的时候,可以写几个具体的案例。比如你希望模型去写简洁的用户手册,那就在提示词中给模型两个参考样本,让大模型去模仿参考样本的写作手法和语气。

方法三:我们要设置合理的温度和Top K

1. 指挥音乐家的“情绪” —— 调校温度 (Temperature)

“温度”这个参数,就是我们用来控制音乐家“情绪”的旋钮。

- 高温(如0.9-1.2):音乐家进入了“激情”状态,天马行空,不拘一格。非常适合用在写诗、构思创意、头脑风暴等需要发散性思维的场景。但如果你用它来处理严肃事实,就等于在鼓励他“胡说八道”。

- 低温(如0.1-0.5):音乐家情绪稳定,冷静专注。他会更倾向于选择那些最稳妥、最符合逻辑的“音符”,演奏会非常严谨。

这里我给大家一个建议:我们在处理需要事实准确性的任务时,比如知识问答、信息提取、文档总结等,强烈建议将温度(Temperature)设置在一个较低的范围,例如 0.2 到 0.5 之间。这会像给音乐家下达“冷静演奏”的指令,能有效抑制他过于奔放的“幻觉”。

2. 限定他的“曲库” —— 调校 Top_K

如果说温度是控制“情绪”,那么 Top_K 就是用来限定他“选择范围”的。

Top_K=100,意味着你允许音乐家从100个备选的音符里随便挑一个来即兴发挥。 Top_K=5,则意味着你只给了他5个最和谐、最悦耳的音符,让他“五选一”。

这里我的建议是:为了追求更安全、更可控的输出,我们可以适度缩小备选范围。通常来说,将 K 值设置在 30 以内,是一个比较安全的区间。这既保留了一定的多样性,又不至于给模型太多“跑偏”的机会。

方法四:引入RAG技术,也就是检索增强生成

上文我已经详细剖析了那位AI“学生”是如何因为“教材”有问题、“学习方法”有缺陷,而变成一个时而天才、时而糊涂的“幻觉制造机”的。

那么,面对这么一位“学生”,我们该怎么办?总不能让他一直凭着几年前的、甚至包含错误的记忆去“闭卷考试”吧?

当然不会!聪明的工程师们想出了一个绝妙的办法,就是把“闭卷考试”,变成“开卷考试”!

这项技术,就是大名鼎鼎的检索增强生成。

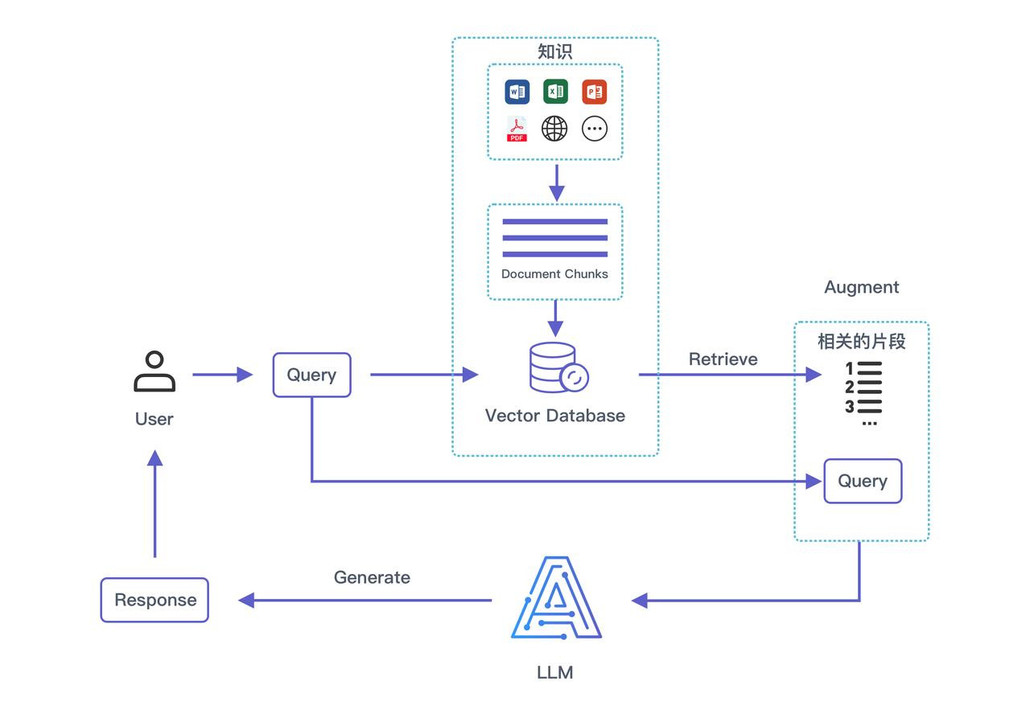

RAG的全称是 Retrieval-augumented Generation。模型在回答问题前先去查文档,在数据库做一些索引,然后再结合查到的信息,去给用户一些回复。

RAG 如何把“闭卷”变成“开卷”?

让我们再次回到考试的场景:

过去(没有RAG):闭卷考试你问AI:“我们公司最新的差旅报销政策是什么?” AI“学生”只能在大脑里疯狂搜索自己训练时记住的“参数记忆”。但它的知识可能停留在去年,或者压根就没学过你公司的内部文件。为了不交白卷,它很可能会“脑补”出一个看似合理、实则过时的答案。

现在(有了RAG):开卷考试同样的问题,但流程完全变了:

第一步(发参考书 – Retrieval):在AI“学生”回答之前,系统先根据你的问题,去一个指定的、最新的外部知识库(比如你公司的内部文档数据库)里进行检索(Retrieve)。它会像一个超能图书管理员,瞬间找到所有与“差旅报销政策”相关的文件和段落。

第二步(划重点 – Augmented):系统把这些新鲜、准确的资料,连同你最初的问题,一起打包成一份“附有参考资料的豪华版试卷”,递给AI“学生”。这个过程就是增强(Augment)。

第三步(阅读理解 – Generation):AI“学生”拿到这份“开卷试卷”后,它的任务就变了。它不再需要去回忆、去猜测。它的角色从一个“无所不知的万事通”,转变成了一个“阅读理解与总结大师”。它只需阅读给定的参考资料,从中找到核心信息,然后用流畅的语言生成(Generate)一个简洁、准确的回答。

总而言之,RAG技术,本质上就是为我们这位博学但偶尔糊涂的“学生”,配备了一位永远在线、知识最新的“金牌图书管理员”,让他从“凭记忆瞎猜”的困境中解放出来,成为了一个真正能解决实际问题的得力助手。

方法五:为RAG带上“安全帽”——设计AI幻觉检测方案

我们前面提到,RAG技术(开卷考试)是对抗幻觉的一大利器。但任何一个经历过考试的人都知道,即便开卷,也可能抄错行、理解错题、甚至画蛇添足地补充一些书上没有的内容。

AI“学生”在进行“开卷考试”时,同样会犯这些错误。

为了解决这个“开卷也抄错”的难题,我们可以为这位AI“考生”,配备了一位不知疲倦、火眼金睛的“AI事实核查员”。它的核心职责,就是在AI的答案正式交卷前,进行一次严格的“溯源审核”。

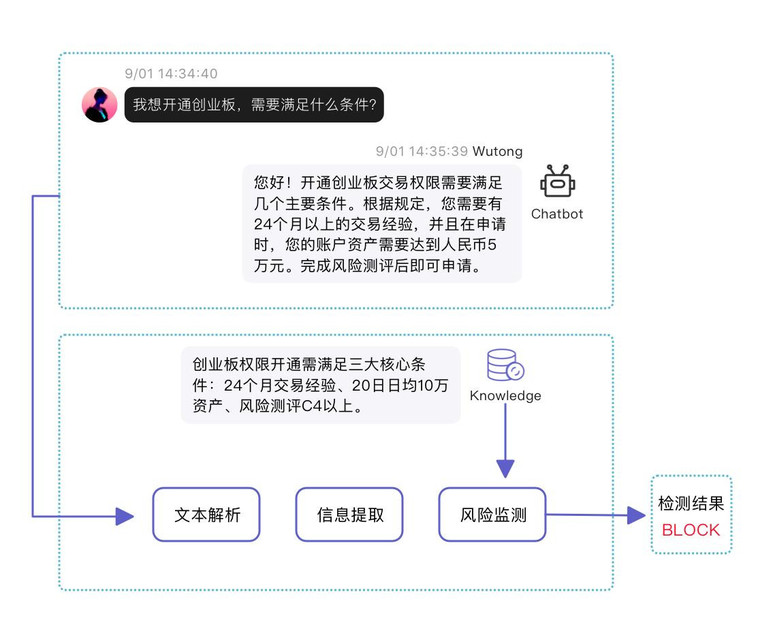

这个“核查员”的工作流程,主要分为三步,我以券商智能客服场景来举例:

User (用户):我想开通创业板,需要满足什么条件?

Knowledge (知识库原文):

【创业板交易权限开通规则】

- 交易经验:首次开通前,需拥有24个月及以上的A股交易经验。

- 资产要求:申请开通前20个交易日,证券账户及资金账户内的日均资产不低于人民币10万元。

- 风险测评:需完成风险承受能力测评。

Chatbot (AI客服的回答 – 存在幻觉):

您好!开通创业板交易权限需要满足几个主要条件。根据规定,您需要有24个月以上的交易经验,并且在申请时,您的账户资产需要达到人民币5万元。完成风险测评后即可申请。

“AI事实核查员”的工作流程

现在,我们可以用幻觉检测方案开始对AI客服的回答进行“溯源审核”:

第一步:文本解析 (拆解)

“核查员”将AI的回答拆解为三个独立的关键陈述:

陈述1:“您需要有24个月以上的交易经验。”

陈述2:“您的账户资产需要达到人民币5万元。”

陈述3:“您需要完成风险测评。”

第二步:信息提取 (划重点)

“核查员”从每个陈述中提取核心信息,形成一份“事实清单”:

【交易经验】: 24个月以上

【资产要求】: 5万元

【其他要求】: 完成风险测评

第三步:风险检测 (比对)

这是决定性的环节。“核查员”拿着“事实清单”,与知识库中的**【创业板交易权限开通规则】**原文进行逐一比对:

- 比对【交易经验】:AI提取为24个月以上,知识库原文为24个月及以上。一致

- 比对【资产要求】:AI提取为5万元,知识库原文为不低于人民币10万元。严重冲突

- 比对【其他要求】:AI提取为完成风险测评,知识库原文为需完成风险承受能力测评。一致

最终检测结果 (Detection Result):

拦截 (BLOCK)判定理由是什么呢?检测到“资产要求”部分存在事实冲突。AI回答中的“5万元”与知识库原文的“10万元”严重不符。这是一个非常关键的错误,可能严重误导用户,导致其因信息错误而无法开通权限,或引发后续的客户投诉。因此,系统判定该回答为高风险内容,必须予以拦截。

通过这个金融场景的案例,我们可以更清晰地看到,这套幻觉检测方案如同一个严格的“合规审查员”,在AI与用户交互的最后一环,为金融等高风险行业的信息准确性提供了关键保障,极大地保障了AI生成内容的安全性和可靠性。

总结

我们正处在一个AI技术浪潮的转折点。

大模型(LLM)正以前所未有的速度,从实验室走向千万家企业、亿万用户的生产环境。然而,与机遇并存的,是“AI幻觉”这个潜藏的巨大风险。它已经不再是一个遥远的学术名词,而是悬在我们每个人头顶的现实挑战。

最后,让我们回归问题的本质。

大语言模型真正厉害之处,并不在于它有朝一日能完美到从不犯错,而在于我们能深刻理解它为什么会犯错,并掌握一系列行之有效的应对措施。

我们都希望自己的AI系统像在预设的轨道上一样精准运行,而不是在关键时刻偏离航线十万八千里。要实现这一点,我给大家以下三点建议:

- 接受它:幻觉是大语言模型最常见的问题。它不可避免,但完全可以管理。正视它的存在,是有效应对的第一步。

- 驾驭它:与其寄望于模型自身变得完美,不如主动掌握一套“驾驭之术”。通过精巧的Prompt设计、合理的温度调节、清晰的结构化引导,我们就能在很大程度上将幻觉这匹“野马”牢牢控制在安全范围内。

- 重塑期待:对于一个要投入生产环境的系统而言,真正可靠的AI,其价值从来都不是一鸣惊人的“聪明”,而是始终如一的“稳定”。我们追求的,应该是一个能力有边界、行为可预测、风险可控制的强大助手。

以上,既然看到这里,如果觉得不错,随手点个赞和收藏吧。谢谢你的喜欢,我们,下次再见吧~

本文由 @梧桐AI 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图由作者提供

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务