字节跳动 发布了一款名为 BAGEL 的开源多模态基础模型,拥有70亿个活跃参数,整体参数量达到140亿。

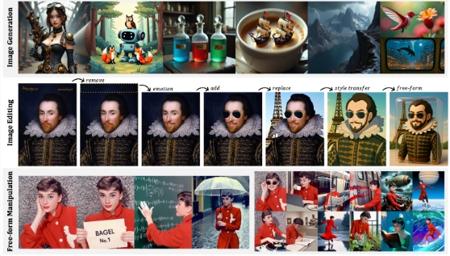

BAGEL 在标准多模态理解基准测试中表现出色,超越了当前一些顶级开源视觉语言模型,如 Qwen2.5-VL 和 InternVL-2.5。此外,在文本到图像的生成质量上,BAGEL 的表现也与强大的专业生成器 SD3相媲美。更重要的是,BAGEL 在经典图像编辑场景中的效果优于许多领先的开源模型。

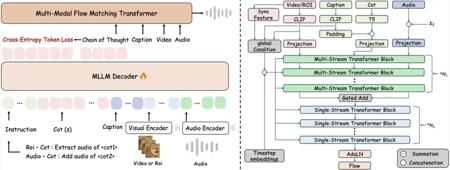

BAGEL 采用了一种名为混合变换器专家(MoT)的架构,旨在最大化模型对多样化多模态信息的学习能力。它使用两个独立的编码器,分别捕捉图像的像素级和语义级特征。模型的整体框架遵循 “下一个标记组预测” 范式,训练时旨在预测下一个语言或视觉标记,从而达到压缩的目标。

在预训练过程中,BAGEL 利用了来自语言、图像、视频和网络数据的数万亿个交错的多模态标记。经过持续训练和监督微调,BAGEL 在标准的理解和生成基准测试中超过了开源模型,展示了先进的上下文多模态能力,如自由形式图像编辑、未来帧预测、三维操作和世界导航等。

随着 BAGEL 的预训练逐步扩大,研究者们发现模型在理解、生成和编辑任务中的表现持续提升。不同的能力在训练的不同阶段出现,早期展现出多模态理解和生成的能力,而更复杂的智能编辑能力则在后期显现。

研究表明,结合变分自编码器(VAE)和视觉变换器(ViT)的特征显著提升了智能编辑能力,强调了视觉 - 语义上下文在复杂多模态推理中的重要性。

项目:https://huggingface.co/ByteDance-Seed/BAGEL-7B-MoT

划重点:

🌟 BAGEL 是一款开源多模态基础模型,拥有70亿个活跃参数,超越多项标准基准测试。

🖼️ 该模型在图像生成和编辑任务中表现出色,能够进行自由形式的图像编辑和世界导航。

📈 通过多模态预训练,BAGEL 展示了持续的性能提升,适应了复杂的多模态推理任务。