李飞飞要用ImageNet的方式,推动具身智能了。

依然是一个“挑战赛”。

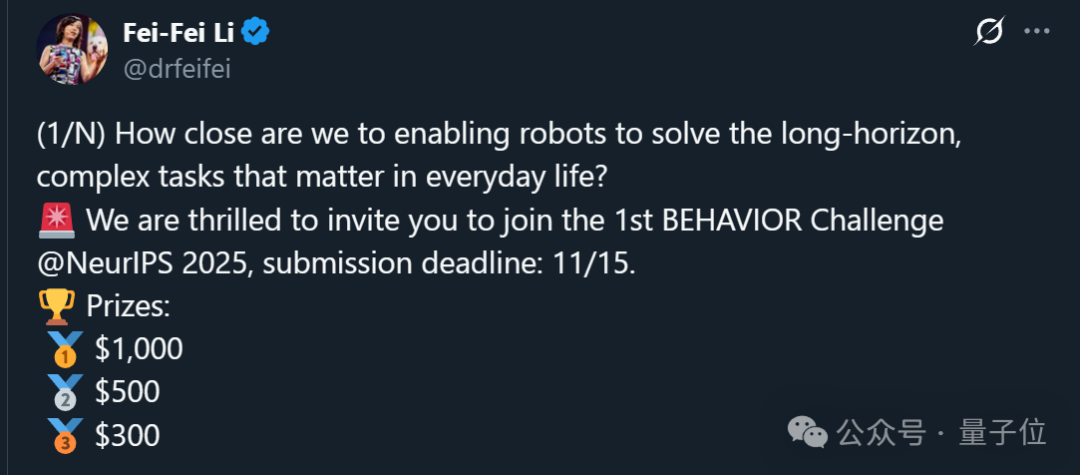

就在最近,由李飞飞团队发起、英伟达赞助(其中之一)的首届BEHAVIOR家务挑战赛正式启动。

这一次,他们下定决心凝聚学术界和产业界的力量,共同向机器人做家务这一高地发起冲击。

简单来说,参赛者需要统一使用星海图R1 Pro(双手操作+轮式移动)作为本体,在逼真的BEHAVIOR-1K虚拟家庭环境中,解决50项完整的家务任务(涵盖重新布置、烹饪、清洁等各种活动)。

参赛者可以自由选择算法,官方还提供了1万条专家演示轨迹(约1200小时),方便大家用模仿学习快速上手。

具体赛道则有两条可选:

- 标准赛道(Standard Track):机器人只能用“自己能看到的东西”决策。

- 特权赛道(Privileged Track):机器人可以获取更详细的环境状态信息(比如物体坐标、房间结构)。

然后官方会在固定的50个任务上,让所有机器人跑相同测试,用以下标准打分(主要):

- 任务完成率:能否完全把任务做完,比如“把餐具放进洗碗机”真的被完成。

- 部分完成度:如果只做到一半,比如“拿起盘子但没放进去”,也会给部分分数。

其他次要指标包括:模拟时间(完成任务用了多长时间)、导航距离(走了多远)、手部位移(动了多少次机械臂)、稳定性等。最终排名主要看平均任务完成率。

比赛提交截止期日为2025年11月15日,最终获奖前三名还有最高1000美元奖金及RTX 5080可拿。

OK,说完比赛内容,那么接下来的问题是——

为什么要发起BEHAVIOR?

关于发起BEHAVIOR的背后原因,李飞飞在和Jim Fan(英伟达具身智能实验室联合负责人、也是李飞飞学生)、 Edmar(英伟达Omniverse社区经理) 的一场炉边谈话中进行了详细阐述。

整体而言,BEHAVIOR的发起正是受到ImageNet的启发。

2009年,李飞飞带领的研究团队在CVPR发表论文《ImageNet: A Large-Scale Hierarchical Image Database》。伴随着ImageNet挑战赛举办,这一成果已然成为了计算机视觉领域的试金石,开启了一个新的时代。

此时再回顾ImageNet,李飞飞坦言最初并未预想到它会完全重塑AI,她只是追随自己的好奇心。

在她看来,ImageNet与神经网络(特别是卷积神经网络)以及英伟达的GPU一起,共同定义了深度学习的开端。

所以这一次,回到当下大热的具身智能领域,她打算用同样的方式再做一遍。

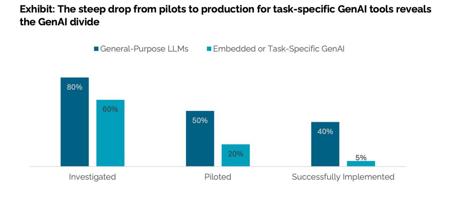

而具体到机器人做家务这件事上,目前机器人学习存在的痛点包括:

- 机器人学习缺乏标准化;

- 任务选择通常是零散的,使得论文之间的结果很难进行比较;

- 训练数据匮乏,这有点类似于ImageNet出现之前计算机视觉领域所面临的问题。

因此,李飞飞将BEHAVIOR也看做机器人领域的“北极星”任务,她希望借助社区力量推动具身智能向前发展。

BEHAVIOR挑战赛有哪些看点?

另外,BEHAVIOR除了自带李飞飞光环,这个挑战赛本身也很有看点。

首先从理念上,BEHAVIOR被设计为以人为中心,尤为强调AI是为了增强(augment)和赋能(empower)人类,而非取而代之。

这种理念贯穿着BEHAVIOR的所有环节。例如,团队会在任务定义、数据选择和伦理价值导向上,来始终确保机器人的目标与人类的需求相符。

其次,BEHAVIOR核心瞄准做家务这一赛道,并首次明确提出了相关标准——

一个真正的家庭机器人,必须同时具备跨房间导航、双手精细操控、长期规划与动态适应等多项能力。

而且为了训练机器人学习相关能力,BEHAVIOR的规模也讲求一个“大”。

它覆盖了1000个家庭活动,50个完整长程挑战,平均单个任务需要6.6分钟连续操作。

所以,以人为本、目标清晰、规模巨大的BEHAVIOR,无疑具备成为“下一个ImageNet”的潜力。至于最终结果如何,一切都要交给时间,毕竟ImageNet也不是一朝一夕成就的。

Anyway,如果说ImageNet开启了视觉智能的黄金时代,那BEHAVIOR,或许正是具身智能的第一声号角。

以及关于机器人做家务这件事,最近也都成了具身智能项目争相整活的任务。以后拍视频,可能就都是家务场景了。

大语言模型的检测是做题,具身智能机器人的检测是做家务。

潮水趋势,已经很明确了。

大赛详情页:

https://behavior.stanford.edu/challenge/index.html

参考链接:

[1]https://x.com/TheHumanoidHub/status/1976355634510737626

[2]https://x.com/drfeifei/status/1976472217438531889

文章来自于微信公众号 “量子位”,作者 “量子位”