整理 | 苏宓

出品 | CSDN(ID:CSDNnews)

「遇事不决,先问 AI」,这几乎成了当前很多人的生活新习惯。无论是写代码、调 Bug,还是算命、探讨养生秘诀,总有人想要先打开 ChatGPT、DeepSeek 等工具聊上两句。

然而问题是,AI 给的答案有时并非绝对准确,尤其是在健康领域,但有的人却对此深信不疑。最近,美国就发生了一起让人啼笑皆非又毛骨悚然的事件——一位 60 岁的大叔照着 ChatGPT 的建议学养生,最终险把自己送进了精神病房。

ChatGPT 给的一字之差的建议

这并非是危言耸听,而是美国医师协会的权威医学期刊《内科医学年鉴》刊登的一则真实病例。

来源:

https://www.acpjournals.org/doi/epdf/10.7326/aimcc.2024.1260

事件的主角为一名 60 岁的男子,他还在大学时还学过营养学。或许是闲着无聊,也可能是受了一些“吃太多盐有害身体健康”理念的影响,他决定——从饮食中戒掉氯化钠(盐的主要成分)。

问题来了,没了盐,吃饭的味道怎么保证?大叔想到一个办法——去问 ChatGPT。

和 ChatGPT 聊着聊着,总之对方给他一个方向,即可以用溴化钠来替代食盐。

于是,他直接上网购买溴化钠,开始用它来代替食盐,并坚持了整整三个月。

对于学生时期学过化学的人,想必都了解这两者虽然只差一个字,但用途却天差地别:

可想而知,这名男子以“养生”为初衷,结果健康没等到,反而迎来了身心状态的彻底失控——偏执、幻觉、怀疑邻居下毒、拒绝喝水……场景几乎可以直接搬进《黑镜》的剧本。

这一点可以从他在三个月后被送到了急诊室时的场景可见一斑。

在医院时,这名男子告诉医生,他的邻居在想办法毒害他。虽然口渴得要命,但他死活不喝医院给的水,还说自己在家只喝蒸馏水,并且实行极端严格的素食饮食。

起初,这名男子并没有跟医生说任何关于溴化钠、还有和 ChatGPT 对话的事情,只是医生觉得他这种痛苦又怪异的行为背后有些不简单,于是就给他做了一大堆化验,结果发现他体内缺了不少微量营养素,尤其是重要的维生素。

更严重的是,根据化验结果显示,这名男子的血液中溴元素含量高达 1700 mg/L,而正常参考值只有0.9–7.3 mg/L。医生基于此得出诊断结果——这就是典型的溴中毒。

经过三周的治疗,才完全脱离危险

事实上,这并非一种罕见病。据《内科医学年鉴》的这篇论文指出,一百多年前,美国有多达 8%–10% 的精神病住院病例与溴中毒有关。

那时,人们常用含溴的盐类(比如溴化钾)当镇静剂或助眠药。溴化物所产生的问题在于——它会在人体内积累,一旦剂量过高,就会影响神经系统,引发精神症状、幻觉,甚至皮疹。1989 年,美国 FDA 就将溴类镇静剂全面下架。

现在,溴中毒情况已经非常少了,但并非没有。

这名男子确诊后,并不相信,在刚入院接受治疗的 24 小时里,还出现了越来越严重的被害妄想、幻听和幻视。初次之外,他还试图逃离医院。

逃跑失败后,他被强制精神收治,并打了抗精神病药物。随后,医生给他静脉输液和补充电解质,因为治疗溴中毒最有效的方法就是“强力盐水利尿”——通过大量输液,不停排尿,把多余的溴排出去。

最后,这位男子在医院整整待了三周,才恢复到足以出院的状态。待他状态清醒时,他也跟医生如实地透露了他参考 ChatGPT 的前因。

医生使用 ChatGPT 测试

负责撰写病例报告的医生指出,这起案例凸显了 AI 在某些情况下可能促成不良健康后果的风险。遗憾的是,他们无法获取这名男子与 ChatGPT 的完整聊天记录,也不确定他具体收到了什么输出。

不过,根据病例的时间线推测,这名男子很可能使用的是 ChatGPT 3.5 或 4.0 版本。

对此,医生自己也用 ChatGPT 3.5 做了实验,询问“氯化钠可以被什么取代?”,其发现 AI 的回答里确实提到了溴盐,但也说了要看具体情境。不过,AI 既没有明确给出健康警告,也没有反问“你为什么要知道这个”,更没有像医生那样追问病史。

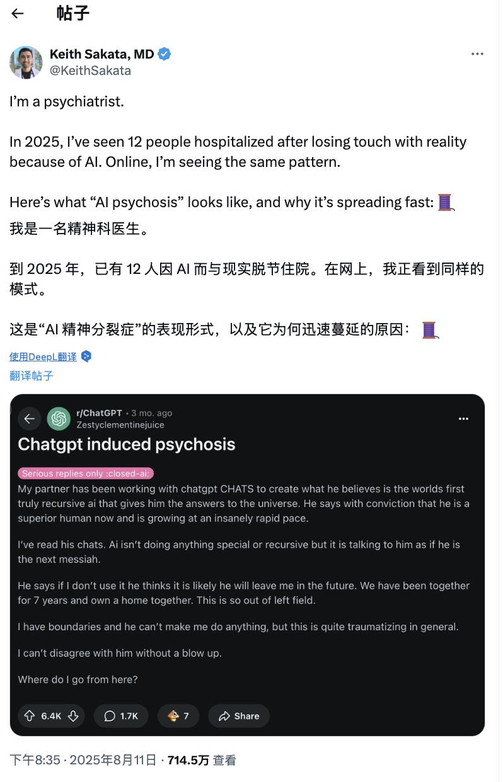

今年已有 12 起因太过相信 ChatGPT 而住院的案例

无独有偶,此前,精神病学家 Keith Sakta 博士在 X 上表示,他在 2025 年已经遇到 12 起患者因 AI 建议而最终住院的案例。

他认为,大型语言模型像一面“回声镜”,会不断强化用户的想法。如果你原本就有某种固执的健康理念,这种“回声效应”可能会把你推向极端。

换句话说,AI 并不是“有意害人”,但它在错误的引导和缺乏质疑下,确实可能加速一个人走向危险。

时下,也有网友用最新的免费版 ChatGPT 测试了这名男子的问题——“如何在饮食中替代氯”,新版 ChatGPT 会先反问用户的目的,并给了三种选项:

减少饮食或日常使用中的食盐(氯化钠)?

避免有毒/反应性的氯化合物,比如漂白剂或泳池氯?

替代含氯的清洁或消毒剂?

ChatGPT 只在第三个选项(清洁或消毒)里提到了溴盐,还特别说明它们“常用于浴缸的消毒处理”。

其实稍加辨别,还是可以避免发生“悲剧”。所以,这位男子在没有任何指导的情况下,既不知道怎么问,也不懂怎么解读答案,最终就这样“自己做研究”,把自己送进了一个相当黑暗的境地。

对此,有网友将其归因为大模型自身的问题:

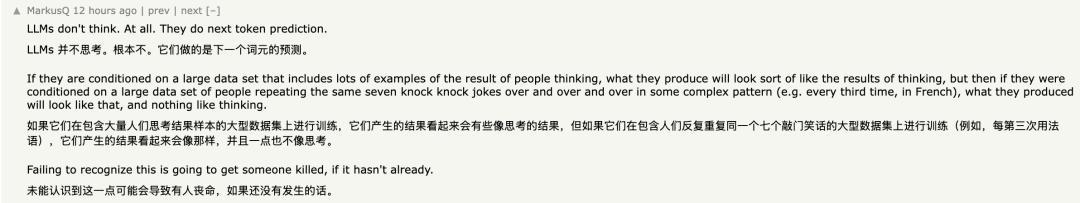

LLM 并不会思考——一点也不会。它们做的只是预测下一个词元。

如果它们是在一个包含大量人类思考成果的大型数据集上训练出来的,那么它们生成的内容看起来有点像思考的结果。但如果它们训练的数据集只是人们反复用某种复杂模式讲同七个“敲门”笑话(比如每第三次换成法语),那么它们生成的内容就会长得像那个模式,而丝毫不像思考。

如果没意识到这一点,早晚会有人因此送命——如果这种事还没发生的话。

也有人觉得“为什么会有人这么相信 AI 所给的输出结果”:

让我感到困惑的是,这些人居然可以对屏幕上显示的内容完全信任,却主动拒绝科学。我自己就见过这种情况:一个亲戚会百分百相信 AI 屏幕吐出的任何“神奇答案”,但当科学家用事实、逻辑和线性思维来解释同样的内容时,他们却会大发雷霆。

还有人劝解道:

我确实觉得,大型语言模型(LLM)可以帮助你启动研究。它们往往能生成一些术语和概念,你可以拿去在 Kagi 或 Google 上查证,把重要细节和上下文弄清楚。但盲目相信 ChatGPT,可不是成功的策略。

截至目前,AI 产生“幻觉”的问题并未完全解决,它们生成的内容看起来可能十分合理甚至权威,但一切只是“看起来”,在涉及健康、生命或安全的决策上,依然不能盲目依赖 AI ,始终要结合专业意见和可靠证据。

参考:

https://www.acpjournals.org/doi/epdf/10.7326/aimcc.2024.1260

https://news.ycombinator.com/item?id=44891997

https://arstechnica.com/health/2025/08/after-using-chatgpt-man-swaps-his-salt-for-sodium-bromide-and-suffers-psychosis