大型语言模型(LLM)本身很强大,但知识是静态的,有时会“胡说八道”。为了解决这个问题,我们可以让它去外部知识库(比如维基百科、搜索引擎)里“检索”信息,这就是所谓的“检索增强生成”(RAG)。但这还不够,更高级的方法是让 LLM 变成一个能自主决策的“智能体”(Agent),它能自己决定“何时搜、搜什么、怎么搜、如何利用搜索结果”,这个过程就叫做“智能体搜索”(Agentic Search)。而要让这个智能体变得更聪明、更自适应,最好的方法之一就是用“强化学习”(RL)来训练它。

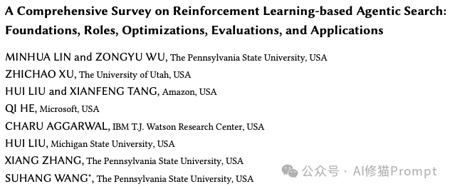

强化学习(RL)正好提供了“和环境交互—拿反馈—改策略”的自适应机制,于是本文写成首篇专门聚焦“基于RL的代理式搜索”的系统综述,来自宾夕法尼亚州立大学的研究者们用三条主轴组织全篇:What RL is for(RL在干什么)、How RL is used(RL怎么用)、Where RL is applied(RL用在何处),再配套评测与应用、开放挑战与展望。带您一文读懂RL如何赋能智能体搜索,从基础原理到评测与应用的全景脉络。

信息检索技术的发展历程

信息检索技术的发展其实是一条不断提升“智能化”水平的道路,理解这条路能帮我们看清当前的位置。最早的传统信息检索(IR),比如经典的BM25算法,就像一个图书馆的“图书目录”,您输入关键词,它给您返回一堆可能相关的书,但具体哪本、哪一页有用,得您自己判断。后来,检索增强生成(RAG)出现了,它更像一位“图书管理员”,您提出问题,它不仅帮您找到相关的书,还会翻到具体的某一页,把内容直接递给您,这大大提升了答案的准确性,但它的工作方式依旧是被动的。

代表性综述与这篇工作的比较。✓表示该主题是主要关注点;✗表示有限或未涵盖

当面对一个真正复杂的问题时,比如“分析一下最近AI芯片市场的竞争格局和未来趋势”,一次搜索是远远不够的。这时候就需要“智能体搜索”登场了,它扮演的是一个“智能研究员”的角色。它会先思考,把大问题拆解成“目前主流的AI芯片有哪些?”、“英伟达、AMD、谷歌的最新产品是什么?”、“市场份额和财报数据如何?”等一系列子问题,然后主动去搜索、阅读、整合信息,甚至在发现信息冲突或不足时,会主动调整搜索策略,再进行新一轮的探索,直到形成一份全面、可靠的报告。这篇论文告诉我们,强化学习正是训练出这种高级“研究员”的关键技术。

强化学习基础:RL如何训练智能体

那么,强化学习(RL)究竟是如何训练智能体的呢?您可以把它想象成一个“教练与运动员”的模型。LLM智能体是“运动员”,搜索引擎、数据库等外部工具是它训练的“场地”(环境),智能体的每一个搜索或推理行为都是一个“动作”。当智能体完成一次任务后,“教练”(奖励函数)会根据最终答案的质量(比如准确率、事实一致性)和过程的效率(比如搜索次数、API调用成本)给出一个“分数”(奖励或惩罚)。

强化学习的核心组件。智能体(Agent)在特定状态(State)下执行一个动作(Action),环境(Environment)会反馈一个奖励(Reward)并进入下一个状态,智能体根据这个循环来学习最优策略。

这个“分数”就是驱动智能体学习的核心信号。通过最大化累积奖励,智能体能逐渐学会,哪些动作序列能带来高分,哪些是无效的“瞎忙活”。研究者们在这篇论文中总结了当前最主流的几种训练算法,比如PPO(近端策略优化)、GRPO(组相对策略优化)和DPO(直接偏好优化),它们各有侧重:PPO像一位经验丰富的老教练,稳定但需要额外的“陪练”(价值网络);GRPO则更轻量,通过让一组“克隆运动员”内部比较来学习,节省了资源;而DPO则另辟蹊径,直接学习“好动作”与“坏动作”之间的偏好差异,过程更简单直接。

三大维度:What、How、Where

维度一:强化学习究竟能做什么?(What RL is for)

您可能会问,RL具体能优化智能体搜索的哪些环节?研究者们将其归纳为五大核心角色,这远比简单地“触发一次搜索”要丰富得多,它贯穿了从理解问题到最终回答的全过程。

- 检索控制(Retrieval Control):这是最基础也是最核心的功能,RL教会智能体进行“成本-收益”分析。它能自主决定一个问题是应该靠自己的内部知识回答,还是必须求助外部搜索;对于复杂问题,它还能学习决定搜索的“深度”和“持久度”,比如要不要进行多轮搜索;最终目标是实现高效搜索,用最少的搜索次数(降低成本和延迟)来解决问题,避免冗余操作。

- 查询优化(Query Optimization):智能体生成的搜索查询质量直接决定了结果的好坏,RL 在这里扮演了“沟通桥梁”的角色。一方面,它能将用户在多轮对话中提出的模糊、依赖上下文的问题,重构成清晰、独立的搜索查询。另一方面,它还能学习特定搜索引擎的“脾气”,生成更符合其索引和排名偏好的查询,从而拿到更高质量的检索结果。

- 推理与检索的整合(Reasoning-Retrieval Integration):高级的智能体搜索不是简单的“先搜后想”,而是“边搜边想、边想边搜”的动态过程。RL能够优化这种推理与搜索交织进行的过程,让推理的中间步骤指导下一步的搜索方向,而新的搜索结果又能反过来修正和深化推理路径。还有最重要上下文与记忆管理,在长周期的搜索任务中,RL还能帮助智能体管理有限的上下文窗口,学习决定哪些信息需要被记住、总结或遗忘。

- 多智能体协作(Multi-Agent Collaboration):对于极其复杂的任务,单个智能体可能力不从心,这时就需要一个“智能体团队”。RL可以用来训练一个“规划者”智能体,它负责任务拆解和指挥,然后将子任务分配给专门的“执行者”智能体(如查询重写器、文档筛选器)共同完成复杂的搜索任务。通过共享的奖励机制,这些各司其职的智能体能够高效协同,共同完成一个宏大的搜索目标。

- 工具与知识的整合(Tool and Knowledge Integration):现代AI应用不仅要会搜索文本,还要会使用计算器、代码解释器、甚至调用视觉模型来分析图片。RL可以训练智能体成为一个“多面手”,根据任务需求,灵活地在网页搜索、知识图谱(KG)或数据库查询、代码执行等多种工具和知识源之间进行选择和组合。

维度二:我们该如何使用强化学习?(How RL is used)

了解了RL能做什么之后,接下来的问题就是具体该怎么操作,这直接关系到您如何将这些理念落地到产品开发中。研究者们从训练范式和奖励设计两个方面给出了清晰的路线图,这对于您在实际开发中非常有指导意义。

- 训练范式(Training Regime):一个非常标准且有效的流程是“SFT冷启动 + RL微调”,您可以将其理解为“先跟老师学,再自己练”。我们先用高质量的“专家范例”对模型进行监督微调(SFT),让它掌握基本的搜索和推理能力,知道“该怎么做”;然后,再通过强化学习(RL)进行微调,让智能体在真实或模拟的环境中自由探索,通过奖励信号学会“如何做得更好”,发现那些专家范例之外的最优策略。为了降低真实API调用的高昂成本和不稳定性,很多工作都在“模拟环境”中完成大部分训练,并通过“课程学习”(由易到难安排任务)来保证训练的稳定性。

- 奖励设计(Reward Design):这是整个RL训练的灵魂,它直接决定了您想让智能体“学成什么样”。奖励可以分为两类:一是“结果级奖励”,它只看最终答案的质量(如精确匹配度、F1分数),有时也会综合考虑效率(如搜索次数)和多样性,这种方式简单直接但信号稀疏,智能体很难知道到底是哪一步做错了。二是“过程级奖励”,它为智能体在搜索过程中的每一步行为都提供即时反馈,例如,对带来“信息增益”的搜索给予奖励,对“冗余搜索”或“不忠实于原文”的行为给予惩罚,这种密集的指导信号对于训练智能体完成长链条、复杂任务至关重要。

- 智能搜索体的提示词模板:研究者在论文中贴出了一个标准的提示词模版,以Search-R1为例:

维度三:强化学习用在系统的哪个部分?(Where RL is applied)

在系统架构中,RL的应用范围也相当灵活,您可以根据产品的复杂度和优化目标,选择在不同层次上应用RL。研究者们将其划分为三个层次,从宏观到微观,层层递进。

- 智能体级别(Agent-level):这是最彻底的应用方式,RL直接端到端地优化一个或多个智能体的完整决策策略。无论是单个智能体还是多智能体系统,它们的所有行为都由一个统一的、通过RL训练的策略来控制,目标是实现全局最优。

- 模块/步骤级别(Module-Level & Step-level):这种方式更加轻量和灵活,它不是优化整个智能体,而是将RL聚焦于系统中的某个特定模块(如一个独立的搜索模块)或某个特定步骤(如查询生成)。例如,您可以只训练一个专门负责“查询重写”的RL模块,或者只在“是否需要搜索”这个决策点上使用RL,而系统的其他部分保持不变,这种“插件式”的优化方式更容易在现有系统中集成和测试。

- 系统级别(System-level):这一层次的关注点在于构建统一的、可扩展的智能体搜索框架和评估基准。比如,像AgentGym-RL或RAG-Gym这样的平台,它们为研究者和开发者提供了一套标准化的环境、算法和评估工具,极大地推动了该领域研究的规范化和可复现性,让大家不再需要从零开始“造轮子”。

评估、应用与未来挑战

当然,一个技术好不好,最终要看它的实际效果和应用前景。研究者们在论文中系统地梳理了用于评估智能体搜索的“考场”(数据集)和“评分标准”(评估指标),以及它已经大放异彩的“应用领域”,这能帮助您更全面地衡量和定位自己的产品。

- 数据集(考场):为了全面测试智能体的能力,学术界构建了多样化的数据集。这包括:需要深度知识的问答(如

NQ、HotpotQA),模拟真实网页环境的搜索任务(如WebQA、GAIA),需要结合图文信息的“多模态搜索”,模拟用户连续提问的“对话式搜索”,以及面向数学、医疗、科学等特定领域的专业基准。这些多样化的“考场”确保了智能体不仅要会“开卷考试”,还要能应对各种复杂、动态的真实场景。

- 评估指标(评分标准):评分标准也变得越来越立体。除了传统的答案质量指标(如精确匹配

EM、F1分数、ROUGE),新的评估体系更关注过程。例如,“搜索效果”指标(如精确率、召回率)衡量找到的信息是否相关;“搜索效率”指标(如查询次数、API成本)评估智能体是否“经济实惠”;而“过程质量”指标(如每一步搜索带来的“信息增益”、对证据的“利用率”)则深入考察其思考过程的合理性。

- 典型应用:基于RL的智能体搜索已经在多个前沿领域展现出巨大潜力。例如,在深度研究领域,它可以像“科研助理”一样自动进行文献综述和假设生成;在多模态搜索中,它能结合图文信息进行商品搜索或数据分析;在代码智能体方面,它能自主搜索代码解决方案、执行并调试;在AI助手中,它能在多轮对话里更智能地理解用户意图,提供精准帮助。

不过,挑战依然存在。如何让智能体在处理文本、图像、音频等多种信息的“多模态搜索”中保持逻辑一致?如何为需要跨越数天甚至数周的“长时程研究任务”设计有效的记忆机制?以及,如何确保智能体在开放网络环境中不被恶意信息误导,保证其行为的“可信赖性”?这些都是亟待今后去探索和解决的课题。

多模态能力的重要性

您可能会特别好奇,在这么多挑战中,研究者们是否强调了某一个特定的方向?答案是肯定的,而且非常明确。在这篇论文的未来挑战部分,研究者们将“多模态智能体搜索”(Multi-modal Agentic Search)放在了首要位置,认为这是该领域走向成熟、解决真实世界问题的关键瓶颈。于这方向近期的热点,您可以看下DeepSeek最新开源的DeepSeek-OCR:

《AI的光学时刻来了,DeepSeek-OCR运行3B参数,仅6.2G,完美!》

论文专门开辟了一个小节来介绍多模态搜索的应用。其中提到了像 VRAG-RL(用于理解富含视觉信息的文档)、Visual-ARFT 和 WebWatcher(结合网页搜索和视觉分析)等前沿工作。这说明多模态搜索已经不是一个纯理论概念,而是有了切实的落地应用和研究方向。

结语

这篇综述论文为我们描绘了一幅清晰的蓝图:通过强化学习,我们可以将LLM从一个被动的知识检索工具,转变为一个能够主动规划、探索和学习的智能体。它不再是简单地执行“检索-生成”的线性流程,而是在一个动态的决策循环中,不断优化自己的信息获取与问题解决能力。研究者在最后的小结中特别强调:真正可用的系统离不开“面向场景的适配、多模态能力、资源效率管理”。

文章来自于微信公众号“AI修猫Prompt”。