从“模型即服务”(MaaS)到“智能体即服务”(AaaS)的转变,标志着AI行业进入了新的发展阶段。我们不再满足于AI的“对话能力”,而是期望它能成为自主完成复杂任务的“全能机器人”。但当我们兴奋地将这些能力强大的Agent部署到生产线上时,却发现传统软件工程的“确定性”基石已不复存在。随机性,这个曾经在实验室里被视为“创造力”的特性,如今正成为生产环境中最大的不稳定因素。

如何驾驭这头充满力量却难以预测的“猛兽”?来自中科院与清华大学的研究者们给出了他们的答案「AgentOps」。这份分量十足的研究报告,第一次为Agent Systemm全生命周期运维提供了系统性的方法论。

对智能体系统的定义

在深入“翻车”现场之前,咱们得先对齐一下,现在我们常聊的“智能体系统”(Agent Systemm)到底是什么。根据研究者的定义,它是一个能感知环境、做决策、并自主完成任务的智能系统,挺像一个数字世界里的机器人。我之前写过一篇类似的文章,感兴趣您可以看下《Context Engineering不是造新词,IBM揭示LLM推理的认知秘密》如今基于大语言模型的智能体,更是有四项核心能力,像它的“四肢大脑”一样:

- 工具调用 (Tool Call):这是它与世界互动的“手脚”。通过调用各种API或工具(比如搜索、计算、查询数据库),它才能获取信息、影响环境。研究者还提到了MCP(模型上下文协议),这很关键,它统一了模型和工具之间的“沟通语言”,让不同模型调用不同工具变得更标准,省去了很多适配的麻烦。

- 推理与行动 (Reasoning and Act):这是它的“大脑”,负责思考和决策。它会根据当前情况进行一步步的推理,然后决定下一步该干什么,比如知名的ReAct框架就是“先思考,再行动”的典型。

- 短期与长期记忆 (Short & Long Memory):就像人一样,它有“临时记忆”(通常是Prompt的上下文窗口)来处理当前任务,也有“长期记忆”(通常是RAG和向量数据库)来存储海量知识,在需要时随时调取。

- 智能体间通信 (Agent Communicating):当一个任务太复杂,一个Agent搞不定时,就需要一个团队了。这项能力就是让多个Agent能互相沟通、分工协作,比如通过A2A(Agent-to-Agent)协议来对话。

同时,根据团队规模,智能体系统也分为两种:一种是单智能体系统(SAS),一个人单打独斗,适合处理推理、对话、或与简单环境交互的任务。另一种是多智能体系统(MAS),一个团队协同作战,适合玩角色扮演、模拟社会现象、或者合作开发软件这种复杂任务。搞清楚了这些,我们再来看它为什么会出问题,就清晰多了。

研究者定义Agent的各种“异常”

在解决任何复杂问题时,首要任务是准确地定义它。就如爱因斯坦所言

The formulation of the problem is often more essential than its solution, which may be merely a matter of mathematical or experimental skill.

对一个问题的阐述和构造,往往比它的解决方案更重要。解决方案或许仅仅是数学或实验上的技巧问题。

研究者们干的第一件事,就是给智能体的各种“不正常”行为做了个系统性的分类,他们称之为“异常(Anomalies)”。这个定义挺有意思的,它不只是说程序崩溃才算异常,而是把从任务开始前(比如给的指令不清不楚)、到执行中、再到任务结束后(比如答案对了但过程是瞎蒙的)所有导致任务失败或效果不佳的情况,都算了进去。

单Agent内部发生的问题

研究者把异常分成了两大类,第一种叫“Agent内部异常Intra-Agent Anomalies”,说白了就是单个智能体自己内部出了问题,像是“大脑短路”了。这种情况其实最常见,具体来说,大概有这么几种:

- 推理异常:这是最典型的,比如Agent突然开始“一本正经地胡说八道”,也就是我们常说的幻觉,给出的信息和事实完全对不上。

- 规划异常:您让它规划个旅游路线,结果它规划出一条根本走不通的路,或者想调用一个不存在的工具,这就是规划上出了岔子。

- 行动异常:好不容易规划对了,但在执行的时候,比如调用API时,因为接口不标准或者配置变了,结果调用失败了。

- 记忆异常:就像人会忘事儿,Agent也会!比如上下文太长,它忘了您最开始提的要求(短期记忆问题);或者从知识库里检索信息时,找错了或者没找到(长期记忆问题)。

- 环境异常:这个比较好理解,就是跑Agent的机器资源不够了,比如CPU、内存爆了,导致任务卡住。

Multi-Agent之间的交互异常

如果说内部异常是“单兵作战”失误,那“智能体间异常Inter-Agent Anomalies”就更像是团队协作时出的问题,处理起来也更麻烦。这种情况发生在多个智能体需要互相配合完成一个大任务的场景里,真的像一个项目团队,会遇到各种沟通和协作上的坑。研究者们也总结了几种典型情况:

- 任务规范异常:源头可能在您这儿,比如您给的需求(Prompt)本身就模棱-两可,导致Agent们不知道该听谁的,甚至互相冲突。

- 安全异常:这个很危险,比如有恶意的Agent混进了您的系统里,像DDoS攻击一样疯狂发消息,或者进行“注入攻击”,把整个系统搞瘫。

- 通信异常:团队大了,嘴就杂了,Agent之间传来传去全是废话,有效信息没几条,结果就是“消息风暴”,谁也干不成活。

- 信任异常:一个Agent该不该相信另一个Agent发来的信息?如果盲目相信,可能会被“猪队友”带偏;如果谁都不信,那还怎么协作?

- 涌现行为异常:这是最诡异的一种,单个Agent看都没问题,但它们凑在一起,就莫名-其妙地产生了一些全局性的、灾难性的行为,防不胜防。

- 终止异常:要么是任务还没干完,它就提前“下班”了;要么是陷入了无限循环,像个无头苍蝇一样打转,直到系统超时。

AgentOps:四个阶段控制随机性灾难

智能体的行为是内在的概率性和不确定性(inherently probabilistic and non-deterministic),复杂自适应系统(complex adaptive system) 运行,其全局行为是无数局部交互的涌现属性。面对上面那么多异常,研究者们提出了一个系统性的解决方案,也就是“AgentOps”框架。您可以把它理解成一套专门为AI智能体系统量身打造的“运维和保障体系”,它不再把Agent当成一个简单的程序,而是当成一个有“心智”的、需要全生命周期管理的对象。这个框架主要分成四个环环相扣的阶段,咱们来详细拆解一下。

阶段一:监控 (Monitoring) 给Agent装上全景摄像头

您知道吗,AgentOps的监控和我们传统搞的运维监控,思路很不一样。传统监控看的是CPU、内存这些“生理指标”,而AgentOps更关心Agent的“心理活动”,它要监控的数据也更特别。

- 传统数据 (Traditional Data):这部分当然也包括,比如调用延迟、Token消耗成本、任务成功率等,但这些只是基础。

- 模型数据 (Model Data):这部分是深入到LLM的“大脑”里去看的,比如模型的内部参数、注意力图(Attention Map)等,这能帮助我们理解Agent为什么会做出某个决策,是不是快要产生幻觉了。

- 检查点数据 (Checkpoint Data):这个想法真的挺妙的,它就像是给Agent的每一步行动都拍个快照,把当时的记忆、环境状态全都存下来。这样一旦后面出了问题,我们就能立刻“倒带”回溯到出问题前的那一刻,进行复盘和修复,简直是调试神器。

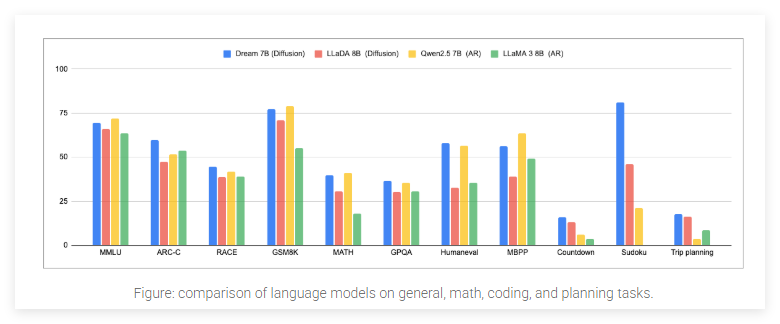

这张表格对比了市面上多种用于LLM或智能体系统的可观测性工具(如Langfuse, MLFlow, OpenLLMetry等),展示了它们在监控指标、日志、追踪等功能上的支持情况。

阶段二:异常检测 (Anomaly Detection) 不仅是“挂了没”,更是“想错没”

传统运维的异常检测,通常是等系统出了问题,比如服务宕机或者接口报错了,我们才能发现。但是,AgentOps的异常检测要主动得多,它追求的是在问题还没造成严重后果之前就把它揪出来。它的核心思路是从“监控系统死活”转变为“判断Agent的想法对不对”,比如通过分析模型内部数据,在Agent刚要产生幻觉、还没输出错误答案的时候,就及时发现并干预。

阶段三:根本原因分析 (RCA) 像侦探一样找到“第一案发现场”

当异常发生后,找到根本原因(Root Cause)是关键,不然就是治标不治本。传统运维找原因,可能最后定位到的是一段代码bug或者一个服务器配置错误。但AgentOps的RCA要复杂得多,因为问题可能出在一些“软逻辑”上,为了解决这个问题,研究者提出了一个非常精彩的RCA三维归因框架。

- 系统中心 (System-centric):这部分是我们比较熟悉的,问题出在“硬”的基础设施上。比如,是不是网络延迟太高了?是不是调用的外部API挂了?或者是不是RAG知识库里的数据本身就是脏数据?

- 模型中心 (Model-centric):这部分问题出在LLM模型本身。比如,是不是模型的核心能力不足,导致它产生了无法避免的幻觉?或者模型的知识库已经过时了,回答不了最新的问题?

- 编排中心 (Orchestration-centric):我觉得这是最核心、也最容易被忽略的一点,问题出在我们指挥Agent的方式上。比如,是不是我们写的Prompt本身就有歧义,让Agent理解错了?或者我们设计的Agent协作流程(Orchestration)不合理,导致它们互相“打架”?

阶段四:解决方案 (Resolution) 告别“一次性修复”,拥抱“持续调优”

找到了原因,就该解决了。但和传统软件打补丁不一样,修复Agent系统的问题不能搞“一锤子买卖”,因为它的行为是概率性的,你改了一个地方,可能会像蝴蝶效应一样引发其他意想不到的问题。所以,研究者提出,解决方案必须是持续的、迭代的,并主要分为两大类。

- 系统设计驱动的解决方案 (System Design Driven Resolutions):这些是从系统架构层面建立“安全网”,属于硬核的工程手段。

- 冗余与投票:别把宝押在一个Agent上,让多个Agent并行执行任务,最后投票选出最靠谱的答案。

- 护栏与断言:给Agent的行为设定严格的边界,比如输出结果必须是JSON格式,或者禁止它调用某些危险的工具。

- 恢复与回滚:前面提到的“检查点数据”就派上用场了,一旦发现走错路,立刻回滚到上一个安全的状态。

- 策略与战略适应:让Agent系统有自适应能力,比如发现某种方法总失败,就自动切换到备用策略。

- Prompt优化驱动的解决方案 (Prompt Optimization Driven Resolutions):这些更像是“心理疏导”,通过优化指令来引导Agent更好地思考和行动。

- 自我修正与内省:通过特定的Prompt,引导Agent在犯错后进行“反思”,自己找出问题所在并进行修正,比如“Reflexion”框架就是这个思路。我去年就介绍过相关的论文,感兴趣您可以看下这篇《卡内基梅隆大学重磅,用这条Prompt让LLM递归内省,多轮交互中自我改进》

- 重新规范与重提示:如果我们发现是自己的指令没给清楚,那就迭代优化Prompt,把任务描述得更清晰、更结构化。您可以参考下《Jina也推新的Meta-Prompt了,盘点OpenAI、Claude顶流元提示(含原文)》

挑战与未来

诚然,AgentOps目前还是一张蓝图,完美落地前仍有诸多挑战。研究作者坦言我们缺乏统一的算法来同时检测五花八门的异常。我们难以在由模型、系统、编排逻辑交织成的“因果迷宫”中,精准地归因。更麻烦的是,对一个局部异常的修复,很可能引发不可预见的“蝴蝶效应”,造成更广泛的系统性失衡。

这是一张信息量很大的总表,它系统地梳理了针对论文中提到的各类异常(如推理异常、规划异常等)的现有检测和缓解方法。感兴趣您可以停留片刻,仔细看一下。

写在最后

我们正试图用管理“确定性系统”的思路,去应对一个“概率性、自适应”的复杂系统,而这种方法正在失效。这是基于Transform架构的AI时代贯穿始终的核心矛盾。

这些挑战共同指向一个结论:管理Agent系统,就像在管理一个复杂多变的生命体。但正是因为挑战如此艰巨,AgentOps框架的提出才显得尤为珍贵。它让我们第一次拥有了一张可以按图索骥的蓝图,去系统性地思考和构建AI产品的稳定性和可靠性。

文章来自于微信公众号“AI修猫Prompt”。