“大模型将是下一代操作系统,超级AI云是下一代计算机。”

在9月24日的2025云栖大会上,阿里巴巴集团CEO、阿里云智能集团董事长兼CEO吴泳铭抛出了这一惊人的论断。他表示,大模型将允许任何人用自然语言创造无限多的软件应用,而这些软件应用将以Agent的形式存在。

这些判断,蕴含着阿里云走向超级人工智能ASI的战略目标。锚定这一智能革命,阿里云在云栖大会上重磅升级了全栈AI体系,实现从AI大模型到AI基础设施的技术更新,将自身定位升级为“全栈人工智能服务商”。本文将针对其中的AI基础设施升级进行全面解读。

AI计算范式的变革

AI大模型催生应用创新百花齐放,对底层的云计算基础设施却是一场严峻的压力测试。传统的云计算架构,在过去十年支撑了移动互联网和数字化的辉煌,但在大模型训练动辄需要万卡并行、Agent应用要求瞬时海量弹性的新范式面前,仍显得愈发力不从心。

正所谓“旧地图找不到新大陆”,行业已经形成共识:简单的“堆卡”无法构筑真正的AI竞争力,AI对基础设施的需求,绝非在传统云上“打补丁”所能满足。根本性的计算范式变革,将不可避免地发生。

我们看到,在海外,英伟达与OpenAI已在联合发力AI基础设施集群;在国内,华为也在推进其“超节点+集群”的战略布局。

那么阿里云呢?吴泳铭指出,计算正从以CPU为核心,加速转向以GPU为核心的AI计算。这预示着,这场围绕AI原生需求的云计算“供给侧改革”,并非零散的部件更新,而是一次从计算、网络、存储到容器的系统性重构,旨在回答一个核心问题:为AI时代而生的云,究竟该是什么样?

从“通用”到“专用”:阿里云如何为AI重构三大件?

传统云计算的设计哲学是“通用”,追求普适性与规模成本效益。而AI云的设计哲学则是“专用”,一切为极致的AI性能服务。阿里云此次对计算、网络、存储“三大件”的重构,深刻体现了这一理念的转变。

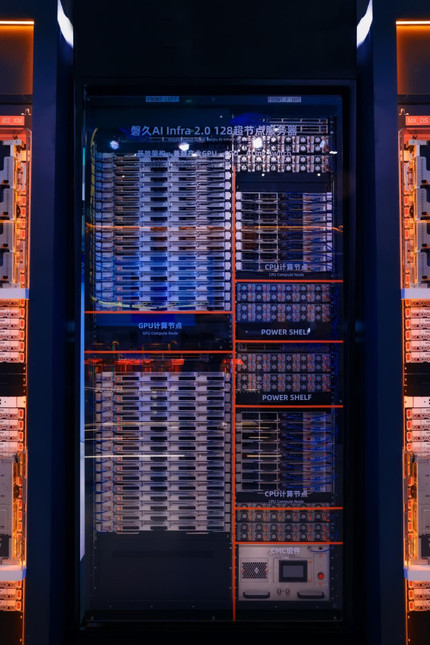

AI大模型训练是典型的高性能计算场景,对算力密度、散热能力和芯片兼容性提出了苛刻要求。传统通用服务器机柜显然无法胜任。为此,阿里云发布了全新自研的磐久128超节点AI服务器。

磐久服务器的核心突破在于“高密度”与“开放架构”:单柜可支持多达128颗AI计算芯片,密度刷新业界纪录;同时,其开放架构能够高效支持产业内多种主流AI芯片。这相当于从最底层的物理基础上,为AI超级计算机打造了一个坚固、高能且灵活的“机身”。

如果说磐久服务器是独立的计算核心,那么高性能网络就是连接万千核心协同工作的“中央神经系统”。在大规模分布式训练中,网络延迟和带宽直接决定了“木桶”的短板。阿里云新一代高性能网络HPN 8.0为此而生。

HPN 8.0采用训推一体化架构,将GPU互联网络带宽提升至惊人的6.4Tbps,并可支持单集群高达10万张GPU卡的高效互联。这意味着,过去因网络瓶颈而难以实现的超大规模集群,如今能够像一台“单一逻辑计算机”般高效运转,网络彻底从“瓶颈”蜕变为“动脉”。

AI工作负载对存储的需求是分裂且极致的。训练阶段,需要以极高速度“投喂”海量数据;而在应用阶段,以RAG为代表的技术则需要对海量的向量化数据进行高效存取。阿里云的解法是分布式存储的“双管齐下”。

一方面,其高性能并行文件存储CPFS再度突破,单客户端吞吐提升至40GB/s,并能提供百万级的IOPS以应对海量小文件处理这一业界难题,彻底解决了训练数据的“进食”效率问题。

另一方面,对象存储OSS创新性地推出了Vector Bucket,为向量数据提供高性价比的海量存储,相比自建开源向量数据库,成本骤降95%。

这样的创新,标志着存储不再只是一个被动的“仓库”,而是一个能理解多模态数据、为上层AI应用提供原生支持的“智能数据引擎”。

从“稳态”到“敏态”:为Agent而生的云原生进化

如果说大模型训练是对基础设施极限性能的考验,那么Agent应用的爆发则考验着云的弹性和敏捷性。未来,数以亿计的Agent将作为人类的“数字员工”24小时不间断工作,其算力需求呈现出“瞬时、海量、碎片化”的特征。这要求云平台必须具备前所未有的动态资源调度能力。阿里云容器服务ACK与ACS的重磅升级,正是对这一未来趋势的前瞻性布局。

针对AI Agent场景的深度优化,阿里云Serverless GPU算力能开箱即用,并创下了每分钟拉起15000个沙箱的大规模并发弹性纪录。同时,模型推理的冷启动速度提升了10倍,GPU故障发现及自愈效率提升了85%。

有了这样的能力,无论是应对突发的推理请求,还是支撑大规模Agent协同工作,阿里云的云原生底座都能实现随需启用、高效响应。这不啻于为即将到来的Agent“洪水”,提前构建了一艘强健且灵活的“诺亚方舟”。

从“黑盒”到“白盒”:全栈优化是终极护城河

在AI时代,单纯提供IaaS层的硬件资源已远远不够,真正的壁垒在于软硬一体的全栈优化能力。如果说基础设施是“身体”,大模型是“大脑”,那么贯穿两者的人工智能平台就是实现身脑协同的“神经中枢”。

阿里云人工智能平台PAI与通义大模型的联合优化,将这种“1+1>2”的全栈协同效应体现得淋漓尽致。通过对MoE模型训练采用统一调度、计算通信掩盖等一系列优化手段,PAI将通义千问模型的训练端到端加速比提升了3倍以上。在推理层,通过全链路优化,推理吞吐TPS增加了71%,时延TPOT降低了70.6%。

这些数据清晰地表明,阿里云正在全力打造一台同时拥有最领先模型和最领先基础设施的“AI超级计算机”,两者在设计和架构上可以高度协同,从而达到极致效率。这种源自内部深度整合的优化能力,是任何外部厂商通过简单采购和拼装硬件所无法复制的,构成了阿里云最深的技术护城河。

结语:中国AI引领者已站在新起点

回顾2025云栖大会的发布,我们可以清晰地看到一条主线:阿里云并非在修补旧世界的地图,而是在绘制新世界的蓝图。它已经率先完成了从“让云适应AI”到“让AI定义云”的深刻变革。

阿里云的领先,不单体现在单个组件的性能指标上,更体现在其构建“下一代计算机”的完整架构思考和全栈协同能力上。这一套被彻底重构的AI原生基础设施,已为其自身的通义大模型家族提供了最强劲的动力,也为其服务中国百万级开发者和企业提供了最坚实的底气。

根据国际权威机构Omdia的报告,2025年上半年,阿里云在中国AI云市场的份额高达35.8%,超过了第二到第四名的总和。在已采用生成式AI的财富中国500强企业中,超过53%选择了阿里云,渗透率位列第一。

我们有理由预测,随着3年3800亿AI基础设施建设计划的推进,这场由阿里云引领的基础设施革命,将进一步巩固其作为“中国AI引领者”的地位,并为整个行业的智能化进程注入更强大的确定性。

但吴泳铭的预测——“未来全世界可能只会有5-6个超级云计算平台”,是否会成为现实呢?