近日,腾讯混元生图团队联合香港中文大学、清华大学共同开源了新一代文生图模型:SRPO!

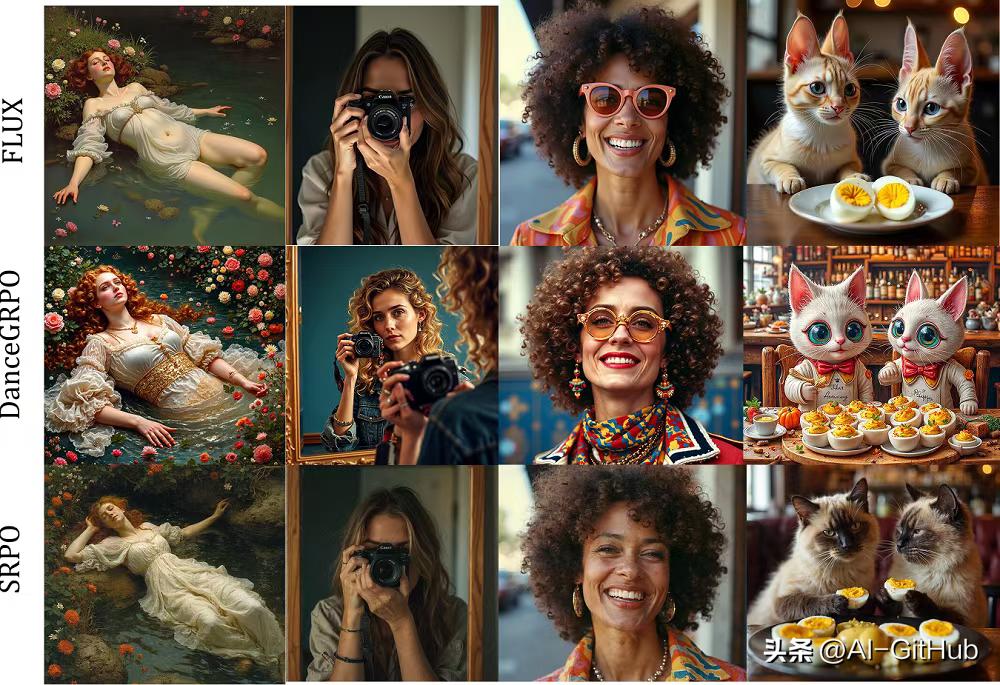

通过创新性的训练优化策略,仅需10分钟训练就能将AI生成图像的美学质量提升300%,显著改善了图像生成质量。

技术创新

Direct-Align采样策略

针对传统多步采样器(如DDIM)计算成本高、易梯度爆炸的问题,SRPO提出单步噪声注入重建法。通过在扩散过程中注入可控噪声并建立"参考锚点",实现更精准的奖励信号传导。实验证明,该方法使重建误差降低37%,解决了高频信息过拟合难题。

语义引导偏好机制

突破传统奖励模型的局限性,SRPO创新性地将文本分支作为模型参数函数。通过动态调整控制提示词(如"真实感""自然光影"),研究人员成功引导奖励模型关注特定美学维度。测试显示,该方法使模型在真实度评测指标上提升312%。

动态负向校正技术

为防止"奖励破解"(模型迎合奖励模型而非真实需求),SRPO采用正向+负向语义词双重引导。通过加权奖励公式平衡训练效率与梯度方向,有效抑制模型对单一风格的过度偏好。

主要功能

提升图像生成质量:通过优化扩散模型,使生成的图像在真实感、细节丰富度和审美质量上显著提升。

在线奖励调整:支持用户通过文本提示动态调整奖励信号,实时改变图像生成的风格和偏好,无需对奖励模型进行离线微调。

增强模型的适应性:使扩散模型能更好地适应不同的任务需求和人类偏好,例如在不同的光照条件、风格或细节层次上进行优化。

提高训练效率:通过优化扩散过程的早期阶段,SRPO能在短时间内(如10分钟)完成模型的训练和优化,显著提高训练效率。

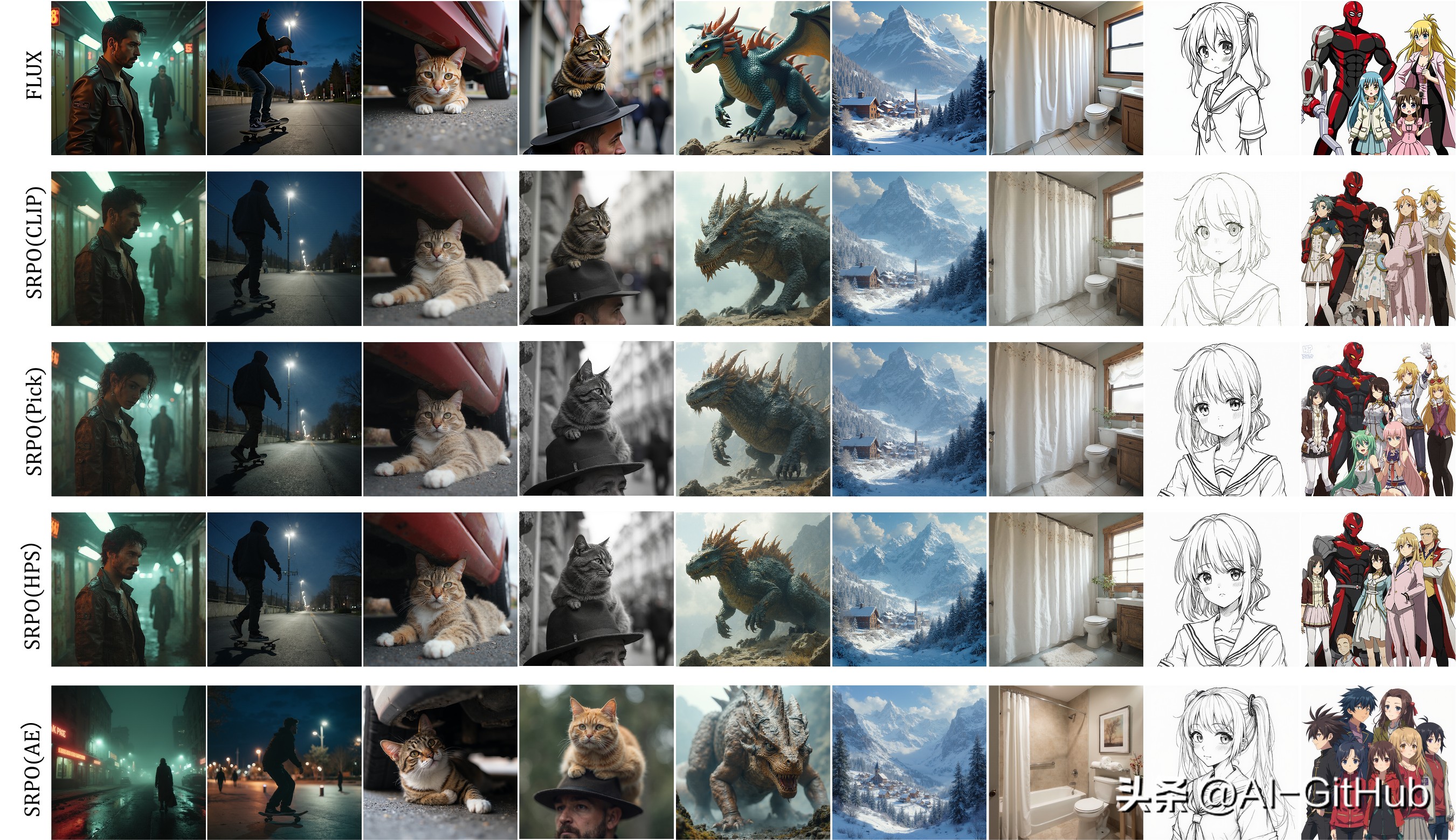

性能表现

在HPDv2基准测试中,SRPO展现出显著优势:

在测试中,Direct-Align方法在Aesthetic predictor v2.5(AE)、PickScore等主流评测指标上均已达到SOTA水平,而结合SRPO后,在AE和PickScore等关键指标上更是取得明显提升。

更为关键的是,SRPO未出现明显的奖励破解现象,验证了Direct-Align的设计能够有效去除奖励偏差,模型真实感显著提升。

应用场景

数字艺术创作:艺术家和设计师生成高质量的数字艺术作品,通过文本提示动态调整图像风格,实现从概念草图到最终作品的快速迭代。

广告与营销:广告公司生成符合特定品牌风格和市场定位的图像,快速生成多种设计选项,提高创意效率。

游戏开发:游戏开发者生成高质量的游戏纹理、角色设计和场景背景,提升游戏的视觉效果和玩家体验。

项目官网:

https://tencent.github.io/srpo-project-page/

GitHub仓库:

https://github.com/Tencent-Hunyuan/SRPO