Wan2.2的重点绝非画质的提升?这篇文章将从MoE专家模型架构的诞生,发展,以及Wan2.2的MoE的不同点。让各位产品经理们对未来AI模型发展的思路和脉络有更深入的认识。

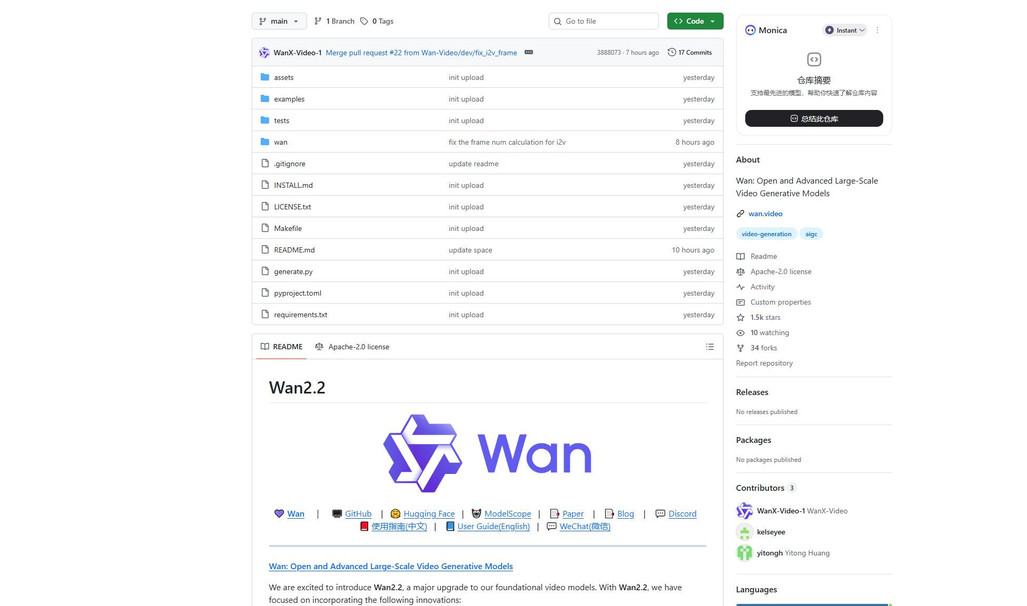

Wan2.2开源地址

- GitHub:https://github.com/Wan-Video/Wan2.2

- HuggingFace:https://huggingface.co/Wan-AI

在本月Wan2.2正式开源了,凭借强大的影视级美学控制能力、高效的复杂运动处理以及灵活的语义遵循功能,为创作者提供了强大的AI视频生成工具。稳坐开源社区AI视频领域头把交椅。乍一看在现在这个AI技术大爆发的时期好像并没有什么两点。但是如果关注模型本身的实现技术,你会发现Wan2.2的强大有着两处非常值得研究的地方。

高压缩比VAE技术:

Wan2.2采用的高压缩比VAE技术,能够在保持数据质量的前提下,大幅减少数据在显存中的占用。这就像是把一个大箱子压缩成一个小箱子,但里面的东西依然完整,从而让显存资源得到更高效的利用。这使得Wan2.2可以高效率的在消费级显卡上部署并且生成创作者想要的视频内容。

高频与低频MOE专家模型技术:

Wan2.2的高频MoE模型擅长细节优化,如纹理清晰度、光影效果和微表情捕捉,让画面更逼真生动;低频MoE模型则负责整体布局,包括场景构建、主体运动规划和长时序动作连贯性,确保视频整体流畅自然。两者协同工作,高效平衡细节与整体,生成高质量视频。

我们这篇文章将会终点从MOE专家模型方面入手,层层拆解。从MoE的诞生,发展以及Wan2.2的MoE到底有什么特别的地方。废话不多说,我们现在开始:

1.MoE专家模型是什么

MoE模型就像个超级团队,各专家身怀绝技,“指挥官”按需挑人,高效搞定任务。

MoE(Mixture of Experts, MoE)是什么:MoE模型就像一个由多个专家组成的超级团队,每个专家各有所长,而“指挥官”(门控机制)会根据任务特点,精准地挑选最适合的专家来完成任务,既避免了“一个人干所有活”的低效,又解决了单一模型面对复杂任务时的力不从心,让整个团队的协作更加高效、灵活,完美地解决了传统模型在复杂任务面前效率低、能力有限的难题。

补充:MoE的诞生历史

- 1991年,Jordan和Jacobs提出MoE架构,借鉴集成学习,用多个专家模型协同工作,门控机制动态选择专家,提升效率和性能。

- 2010年后,深度学习快速发展,MoE架构与深度学习技术结合,成为研究热点、

- 2017年,Google将MoE架构引入Transformer,进一步提升了模型性能,解决了长距离依赖问题。

- 2021年,Google发布GShard,优化了MoE架构在大规模分布式训练中的性能,使其能够处理更大规模的数据。

- DeepSeek-R1模型于2025年1月20日正式发布,成为开源推理模型

2.Wan2.2采用MoE模型为什么值得关注

- Wan2.2是第一个将MoE引入扩散模型完成商业落地的开源模型。这将是人人都可以在本地部署的视频模型。

首先我们先来了解传统“MoE大语言模型”和“MoE扩散模型”之间工作方式的区别

传统的MoE大语言模型:

传统MoE就像请一群专家开会,但每次只让最懂的那一两个发言,既省钱又高效。

传统的大语言模型(LLM)中的 MoE(Mixture of Experts,混合专家模型)是一种通过稀疏激活参数来扩展模型容量的技术。其核心思想是:将一个大模型拆分成多个“专家”子网络,每次推理时只激活少数几个专家,从而在保持计算效率的同时大幅提升模型容量。

MoE扩散模型:

想象你在修一张被雨滴模糊的照片,但雨滴有大有小:先泼瓢泼大雨(大噪声),再下毛毛雨(小噪声)。扩散模型的 MoE 就像请来一组“修图师傅”,每人专门对付一种雨点大小。每次轮到当前雨点时,一个“小管家”只看现在雨多大,立刻挑最擅长这种雨点的师傅出手,其他师傅喝茶休息。

扩散模型中的 MoE(Mixture-of-Experts)并非简单地把 Transformer-MoE 原封不动搬过来,而是围绕“时间步条件化”与“去噪专家专业化”两个核心需求重新设计的。

- 时间步条件化:“现在进行到第几步”当成提示牌——雨下得越大,就去找最会修暴雨图的师傅;雨小了,就换修细雾图的师傅。每一步都先看“进度条”,再决定叫谁来干活。

- 去噪专家专业化:把“修图师傅”按雨点大小分组,暴雨师傅只练暴雨图,毛毛雨师傅只练毛毛雨图,各练各的绝活,互不掺和。

总结:传统 MoE大语言模型 “按问题内容找人”,一个问题对应一个专家模型进行解决。扩散 MoE “按照事情发展时间找人”,就像下雨一样刚开始倾盆大雨交给老师傅模型,雨变小后交给小师傅模型。

Wan2.2采用MoE扩散模型带来的改变和意义

- 画质并没有下降:落地性和商业化质量可保证。

- 生成速度提升:提速约1.6X,同样的视频在更小算力的显卡上生成效率反而更高。

- 显存与算力要求大幅度下降:同一画质下从≈21GB降到≈13GB,RTX4090/3090这类消费级24GB卡就能“一人吃饱”。推理FLOPs因稀疏专家只激活2/8而砍掉约35%,生成720p/24fps片段时,原先要45秒,现在28秒完成——单卡即可本地跑,无需A100/多卡并行。

3.Wan2.2可畅想的落地场景

Wan2.2 已经把“拍电影的 AI 剧组”打包进一台显卡里,场景几乎可以从个人 Vlog 到商业大片都能覆盖。

个人/UP 主短视频

设备:RTX 4090 24 GB 单卡即可跑 TI2V-5B,2.5 分钟出 5 秒 720p/24 fps 短片

电商广告小剧组

方案:TI2V-5B + LoRA 微调自家商品→ 8 小时批量生成 100 条不同机位、光影的 SKU 视频,节省拍片预算 90%。

教育课件动效

场景:K12/大学 MOOC,把 PPT 导出图片 → I2V-A14B 转成 5 秒动画演示,教师无需动画基础。

游戏过场 & 概念 PV

方案:T2V-A14B 生成 480p 原型 → 美术再精修

影视 Pre-viz(预览分镜)

场景:网剧/广告片,导演直接写「手持跟拍、逆光、暖色、长焦」→ Wan2.2 即时出 5 秒动态分镜,省去故事板手绘。

直播虚拟背景

场景:带货直播间,TI2V-5B 实时循环 3 秒背景视频,4090 显卡占用

一句话总结:从 6 GB 显存笔记本到 80 GB 工作站,Wan2.2 给出了“能跑就能拍电影”的阶梯式方案,真正把 AI 视频写进了个人创作者、中小团队、甚至传统影视工业的日常流程。

本文由 @产品经理小易 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议