这应该是上线以来案例最少的 Agent 了,

OpenAI GPT Agent

奥特曼你不给我用,就别怪我用 Manus 跟你硬碰硬了。

先上结论,GPT Agent已经开始向Pro、Plus和Team用户推送,Pro每月400条消息,其他付费用户每月40条。原有的Operator(浏览器操作智能体)几周后会停止服务,原来的深度研究(Deep Research)会被收到下拉菜单里,Agent成功上位。

通过对话框里的工具(Tools)下拉菜单选择 “Agent mode” 就能调用 GPT Agent。

GPT Agent 目前能调用的工具用有图形浏览器(类似Chrome、Edge、Safari)、文本浏览器(类似Lynx,只显示纯文本内容的浏览器)、终端(也会叫命令行)和各种APIs。

这个Agent理论上会自己选择最佳路径,包括运行代码,生成幻灯片和电子表格,同时在各个步骤中保持完整的上下文,是支持随时打断并接管浏览器的。随时打断也是OpenAI Operator、Manus的常规功能了,没啥新鲜的。

比较有意思的一个点是在执行的过程中,GPT Agent 还会把自己的内心旁白写到操作界面上,我可以第一时间理解它在做什么。

说了那么多,直接上案例!

评分这类纸面实力我们留到后面。

我要先吐槽吐槽发布会上跑的案例非常细碎,发布会也就25分钟,我看最长的那个案例都花了23分钟,一会展示A、一会展示B、再过会C来了。。。

怪不得这次拉了五个人上来,可能是因为Agent运行的时间太长,按照之前的四人配置唠不了那么久。但一次拉那么多人上直播真的没问题吗?别下周又被Meta挖走了。

还是先来看看GPT Agent PPT做的怎么样吧,也是被吐槽最多的点。

做的PPT太素了,

从云端硬盘获取ChatGPT智能体评估数据并制作PPT,无需引言或结语部分,直接用图表展示结果即可。

这样看其实还好吧。

但同样是做ppt,提前拿到内测资格的人跑出来的是这样:

这几张图都被盘包浆了,不夸张地说每一家能做PPT的Agent都可以秒杀这个。同样的提示语在Manus上表现怎么样?

因为不确定原来的文件长啥样,所以我第一次是让Manus自行搜索,

没想到变相增加了难度,做出来的图表还没 GPT Agent 好。

第二次我把刚刚那个素到不行的PPT的同款提示语丢给Manus了。

OpenAI 这波确实没得洗,

硬要说的话 GPT Agent 的长处是画图和数据处理,反而不是文字排版。

再看看第二个主case,也是发布会第一个case

"我们的朋友今年晚些时候要结婚了!这是婚礼网站:

www.zola.Com/wedding/minniaandsarah

请协助完成:

a.匹配所有活动的着装要求(男装)

b.提供约5套方案:符合场地风格和天气的中高端单品

c.查找酒店(婚礼前后预留缓冲日)

d.通过Booking. com操作,需核实实时价格与空房

e.准备500美元以内的礼物(优先查登记处,无则选精品)

f.制作一份完整报告"

输出形式是报告,按理来说就是 GPT Agent 的舒适区,毕竟内置了Deep Research,感觉要不是提示语里面指定了网址和操作的话,原版 Deep Research 的结果会比找这更详细。。。

我来讲解一下,报告首先概述了婚礼和早午餐的时间、地点及当地天气情况(第1部分);接着,根据“黑领结可选”的着装要求和当地气候,推荐了多款中高档西装/礼服(第2部分)和配套的9.5码正装皮鞋(第3部分);然后,报告为9月19-24日的五晚住宿提供了四个酒店选项,并列出了价格和亮点(第4部分);最后,由于新人的礼物清单未公开,报告建议了一款价格低于500美元的 Sonos 智能音响作为礼物(第5部分)。

同样的提示语下,Manus中间执行操作基本也是网页浏览(点击、滑动)、联网搜索等,

在逐字对比两个的报告后,我和裁判 Gemini-2.5-pro 给出的答案是GPT Agent出来的报告更好:

GPT的报告缺点是错误地判断了礼物清单的公开性,但它为用户提供了高度具体、可直接执行的建议,例如推荐了特定品牌的西装和皮鞋,并且其酒店推荐都集中在与婚礼地点(Wailea)一致的区域。

Manus的报告它只提供了着装的风格方向而非具体商品,而且推荐的酒店大多位于距离较远的 Kaanapali 地区 ,降低了对参会者的便利性。

第三个,也是最难的case是旅行数据分析,

第一遍看的时候我也没看出来,因为这个case没有输入的镜头,是因为跑好了直接切换出来的。

构建并预定在漂亮国境内参观所有30个职棒大联盟(MLB)球场的最佳行程(从旧金山出发)

要求概述:

a.目标: 规划在2025年例行赛期间,从旧金山出发(起始日期:明天,即7月16日),参观所有30个MLB球场。

b.灵活性: 本人正在休年假中,时间安排灵活。

c.行程核心:

- 返程(Backtracking): 不必要的绕行或回头路。

- 空闲日(Idle Days): 在没有比赛可看的城市停留过多时间。

- 通勤时间(Transit Time): 城际交通所花费的时间。

- 使用 MLB官方赛程 确定每个球队何时进行主场赛事。

- 优化路线: 设计一条旅行路线,最大限度地减少:

d.赛事偏好(优先级):

- 优先选择日场比赛(Day Games)。

- 优先选择标志性的对决(Iconic Matchups)。优先安排任何可用的主题推广之夜(Promotional/Theme Nights)——特别是凯蒂猫主题之夜(Hello Kitty Nights)。

e.每一站信息: 对于每个目的地(球场),需要包含:

- 球场名称

- 球队名称

- 对手球队

- 比赛日期和具体时间

- 从前一个城市的交通方式(例如飞机、火车、自驾)

- 建议的酒店区域

f.最终输出:

- 一份详细的电子表格(Spreadsheet),包含以上所有信息。

- 一张美观的可视化地图(例如标注清晰的漂亮国地图?)。

- 包含行程的总预计时长,以及可选休息日的安排。

g.额外要求(Bonus):

- 在行程中特别标注(Flag) 那些以最棒美食或球迷体验闻名的球场,以便优先考虑或在时间充裕时重点体验。

可以看到GPT列出的数据是很详细的,并且顺利完成了顺路规划,这个顺路图一打眼看上去还有点小震撼,在这么大的数据处理量下依然成功完成任务。

同样的提示语下,Manus就拉跨了,我跑了三次,最短一次20分钟,最长一次60分钟左右,烧了快8000积分,实在是烧不动了。。。

搜索时间表、文件下载、文件格式转换都没啥问题,就卡在规划最佳路线上了。

目前看来GPT Agengt最大的败点还是拿ppt当卖点。明明数据处理能力是相当不错的,在后面的数据表也能体现出来。

最后一个case是唯一一个图像相关的,

为我们的 GPT Agent 发布制作团队宣传品——根据附件中的团队吉祥物照片设计可爱搞怪的动漫风格图案,将其制成 1x1 英寸的笔记本电脑贴纸,并订购 500 份寄至旧金山佛罗里达街 575 号。

GPT,我问你我那么大只狗呢?贴纸在哪里啊?光看到最后的订购了。

再看看 Manus 表现怎么样,

Manus做的还是挺可爱的,和我提供的原图狗狗形象一致,看完我都想给我家猫猫也做一套贴纸玩玩了。

完成贴纸设计之后,两个Agent都选择了让用户最后的时候输入自己的信息完成下单。这一趴的话没有拉出差距。

我还是那句话,

奥特曼你就不应该把PPT作为宣传主力啊。

最后来看看指标吧,

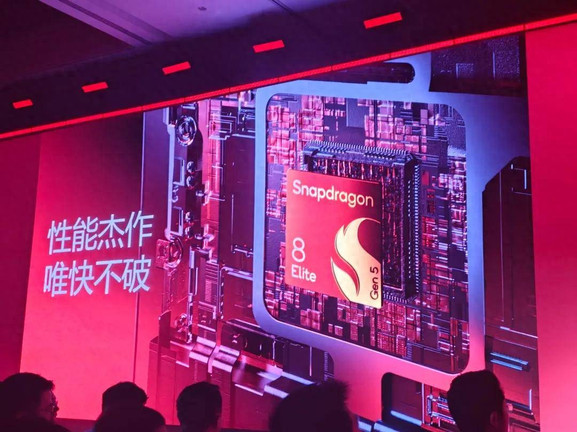

在人类的最后考试 Humanity’s Last Exam (HLE) 中,GPT Agent 的得分达到了 41.6,如果允许它运行八次,选一次可信度最高的话,提分还可以提升到44.4,跟隔壁Grok 4 Heavy(工具增强版)持平。

在FrontierMath(已知最难的数学测试)里,

GPT Agent的准确率达到了 27.4%,比o3高了17.1%

在 BrowseComp(评估 Agent 信息检索能力数据集) 上,GPT Agent的得分是 68.9% ,比 Deep Research 高出 17.4。

在真实电子表格编辑任务 SpreadsheetBench 数据集中,ChatGPT Agent 准确率达到 45.5%。

在 DSBench 数据科学基准测试中,GPT Agent 在数据分析和数据建模两打任务上超越了人类专家。

一句话总结,

GPT Agent是一个擅长解决各类学科问题、能完成网页浏览和信息检索,在电子表格上编辑有优秀性能的Agent。

是不是应该叫学科Agent啊,

仔细想想OpenAI好像也没说自己是通用Agent。

写在最后

昨天风评两极分化都给我整迷糊了,

我自己第一次看的时候就觉得没啥特色,第二次看内测用户放出来的ppt案例觉得是垃圾。

但是为什么他们发布会上做的两页ppt会比放出来的效果好那么多呢?

所以,我才写决定写下这篇文章,

去测测看到底是不是真的拉。

但是还是有反转啊,

Manus优势没那么大,

GPT Agent也没想象那么拉跨。

我还是那句话,

奥特曼给我点钱吧,

我给你当PR,

明明就有更好的,

你到底藏啥呢?!

文章来自于微信公众号“卡尔的AI沃茨”,作者是“AI沃茨”。