算力飙涨、豪气堆料,AMD全面展露全栈AI实力。

智东西美国圣何塞6月12日现场报道,今日,年度AI盛会AMD Advancing AI大会火爆开幕,全球第二大AI芯片供应商AMD亮出其史上最强AI新品阵容——旗舰数据中心AI芯片、AI软件栈、AI机架级基础设施、AI网卡与DPU,全面展露与英伟达掰手腕的雄心宏图。

xAI技术团队成员Xiao Sun、Meta工程副总裁Yee Jiun Song、甲骨文云基础设施执行副总裁Mahesh Thiagarajan、HUMAIN CEO Tareq Amin相继登台,与AMD董事会主席及首席执行官苏姿丰(Lisa Su)博士对谈。

OpenAI联合创始人兼CEO Sam Altman作为惊喜嘉宾压轴登场,透露OpenAI团队在MI300X和MI450上开展了一些工作。他评价说,MI450的内存架构已为推理做好准备,相信它也会成为出色的训练选择。

此次AMD最新发布或预览的重点产品包括:

1、数据中心AI芯片AMD Instinct MI350系列:采用3nm制程,集成了1850亿颗晶体管,基于AMD CDNA 4架构,搭载288GB HBM3e内存,内存带宽达到8TB/s,单GPU可运行5200个参数的大模型,FP4/FP6精度下峰值算力达到20PFLOPS,达到上一代MI300X的4倍,推理性能达到上一代的35倍;跑DeepSeek R1模型时,推理吞吐量超过英伟达B200。

2、数据中心AI芯片AMD Instinct MI400系列(明年推出):专为大规模训练和分布式推理而设计,将FP4精度下峰值算力翻倍提升至40PFLOPS,FP8峰值性能达到20PFLOPS,搭载432GB HBM4内存,内存带宽达到19.6TB/s,每GPU横向扩展带宽达到300GB/s,可实现跨机架和集群的高带宽互连,旨在训练和运行拥有数千亿和万亿级参数的大模型。

相比MI355X,MI400系列的性能提升高达10倍。

相比MI355X,MI400系列的AI计算性能猛蹿新高

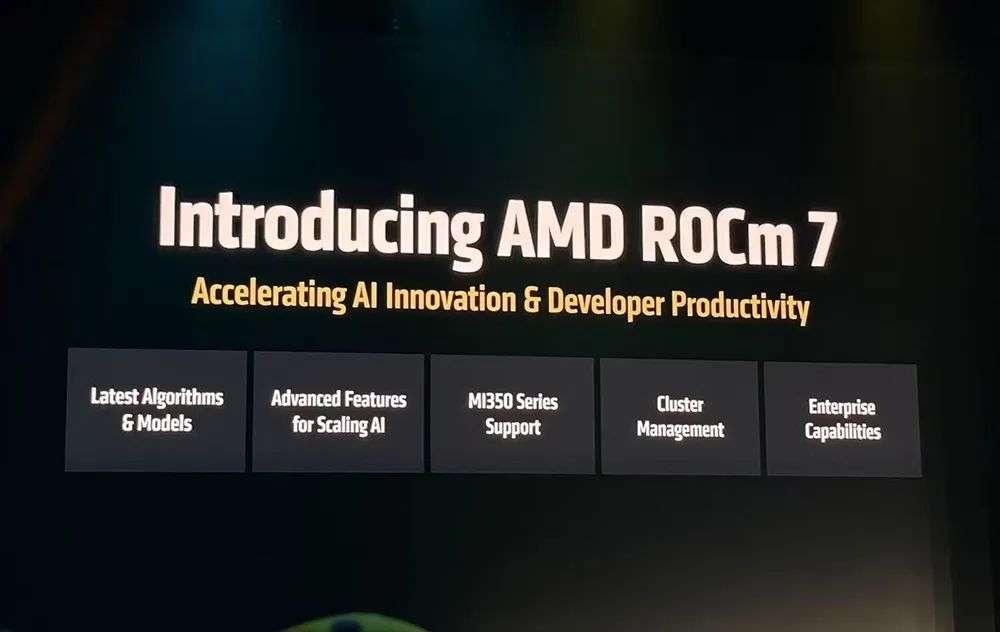

3、全新AI软件栈ROCm 7.0:相比上一代,推理性能提升至4倍以上,训练性能可提升至3倍,实现对GPT、Llama 4、DeepSeek、Grok、Gemma 3、Qwen、Command R+、Mistral AI等许多主流模型的Day 0级支持,可在笔记本电脑和工作站上开发,首度支持Windows系统。AMD还首次推出开发者云。

4、下一代“Helios”AI机架级基础设施(明年推出):AMD首个AI机架级解决方案,进一步提升AI计算密度和可扩展性,支持多达72块MI400系列GPU紧密耦合,支持260TB/s的扩展带宽,支持UALink,FP4峰值算力达2.9EFLOPS。

苏姿丰博士称Helios是“世界上最好的AI机架级解决方案”。

与采用英伟达下一代Vera Rubin芯片的Oberon机架相比,Helios AI机架拥有同等的GPU域、纵向扩展带宽,FP4和FP8精度下的性能也大致相同,HBM4内存容量、内存带宽、横向扩展带宽分别提升50%。

Helios集成了AMD EPYC “Venice” CPU、MI400系列GPU和Pensando “Vulcano” NIC网卡。

其中AMD EPYC “Venice”服务器CPU将采用2nm制程,基于Zen 6架构,最多256核,CPU-to-GPU带宽翻倍,代际性能提升70%,内存带宽达到1.6TB/s。

苏姿丰博士还剧透了将于2027年推出的AMD下一代机架级解决方案。该方案将集成EPYC “Verano” CPU、MI500系列GPU、Pensando “Vulcano” NIC。

AMD有三大AI战略支柱:领先的计算引擎,开放的生态系统,全栈解决方案。现场,苏姿丰博士展示了AMD端到端AI计算硬件产品组合。

全新Instinct MI350系列、ROCm 7软件、AMD开发云、AMD Threadripper和Radeon AI解决方案,都将在今年问世。

苏姿丰博士谈道,AMD相信开放的生态系统对AI未来至关重要,并且是唯一一家致力于硬件、软件和解决方案开放的公司。

01.MI350系列:内存容量比B200多60%,8卡峰值AI算力达161PFLOPS

据苏姿丰博士分享,数据中心AI加速器TAM市场将每年增长60%以上,到2028年达到5000亿美元,预计推理将在未来几年内每年增长80%以上,成为AI计算的最大驱动力。

AMD履行Instinct GPU路线图承诺,继2023年发布MI300A/X、2024年推出MI325后,MI350系列今年第三季度上市,下一代MI400系列将在明年推出。

目前全球10大AI公司中,有7家正大规模部署AMD Instinct GPU。

MI350系列GPU是AMD当前最先进的生成式AI平台。MI350X和MI355X采用相同的计算机体系结构和内存,MI350X更适用于典型板卡功耗(TBP)较低的风冷,MI355X的训练吞吐量、效率、功耗更高,更适用于液冷。

和英伟达B200/GB200相比,MI355X的纸面性能同样能打,内存容量多出60%,FP64/FP32、FP6精度下的峰值性能翻倍提升,FP16、FP8、FP4精度下峰值性能相当。

相比上一代MI300系列,MI355X重点对低精度数据类型进行了优化。FP16/BF16数据类型吞吐量提高到4k FLOPs/clock/CU,FP8数据类型吞吐量增加到8k FLOPs/时钟/CU,FP6/FP4数值格式支持2倍的每CPU FP8速率。

从表格中可以看到,MI355X的向量FP64峰值性能会比MI300X略低,矩阵FP64峰值性能几乎只有MI300X的一半。

8卡MI355X总共有2.3TB HBM3e内存、64TB/s内存带宽,FP4/FP6精度下峰值算力可达到161PFLOPS。

MI350系列GPU采用UBB8版型。每个节点搭载8块GPU,通过153.6GB/s的Infinity Fabric双向链路进行通信。

风冷机架最多可配备64个MI350系列GPU、18TB HBM3e。直接液冷机架最多可配备128个MI350系列GPU、36TB HBM3E,可提供高达2.6EFLOPS的FP4性能。

02.1850亿颗晶体管,多种先进封装混搭

MI350系列采用增强的模块化Chiplet封装,晶体管数量从上一代的1530亿颗增加到1850亿颗,但核心总数减少。

和前代相似,MI350系列GPU采用了多种3D和2.5D先进封装技术。

采用台积电N3P工艺的8个加速器Complex die(XCD)堆叠在2个采用N6工艺的I/O base die(IOD)上。每个XCD有32个CU(计算单元)、4MB L2缓存。AMD还给每个XCD预留了4个CU,这些CU会根据需要被禁用。IOD包含128个HBM3e通道、256MB Infinity Cache、第四代Infinity Fabric Link。

中间Infinity Fabric先进封装对分带宽提升到5.5TB/s,通过Chiplet集成和统一内存架构实现更高的灵活性和扩展性,并通过降低总线频率和电压来降低非核心功耗。GPU与其它芯片通信用的4代Infinity Fabric总线带宽达到1075GB/s。

相比上一代,MI350系列增加了更多内存容量和内存带宽。

通过矩阵核心增强和灵活的量化控制,与MI300X相比,MI350X的每CU峰值HBM读带宽提升多达50%。

03.跑DeepSeek R1提速高达3倍,推理成本远低于B200

推理方面,当运行Llama 3.1 405B大模型,执行AI Agent与聊天机器人、内容生成、摘要总结、对话式AI等广泛AI用例时,相比上一代MI300X,MI355X能实现2.6倍~4.2倍的推理性能提升。

无论是运行DeepSeek R1、Llama 3 70B还是Llama 4 Maverick,MI355X都能实现3倍于MI300X的推理性能。

在采用相同GPU数量、以FP4精度运行DeepSeek R1和Llama 3.1 405B模型时,相比英伟达B200使用自研TensorRT-LLM推理引擎,MI355X使用SGLang、vLLM等开源推理框架的推理性能可提升20%~30%。

运行Llama 3.1 405B模型时,MI355X使用vLLM的推理性能,与GB200使用TensorRT-LLM的性能相媲美。

与B200相比,MI355X每美元可提供多出40%的token,相应也就能提供更低的推理成本。

训练方面,与上一代MI300X相比,在FP8精度下进行Llama 3 70B模型预训练,MI355X可提供3.5倍的吞吐量;在微调Llama 2 70B时,MI355X可实现多达2.9倍的加速。

与英伟达B200、GB200相比,MI355X也能取得同等甚至更高的预训练或微调性能。d

这意味着理论上MI355X能实现更快的训练和推理,缩短从模型开发到部署的时间。

04.ROCm 7:超3.5倍推理性能提升,支持桌面端与Windows

AMD的开源软件战略正在取得成效。在开源社区帮助下,AMD软件生态系统发展突飞猛进。

ROCm软件栈是AMD为前沿模型训练和大规模推理而设计的统一架构,在计算密度、内存、带宽、扩展、互连方面提供领先优势。

AMD ROCm软件生态系统持续优化推理和训练性能,对Llama、DeepSeek等主流模型实现Day 0级支持,将发布节奏从每季度加快到每两周,持续改善开发者的开箱即用体验。

AMD还增加了捐赠开源社区的GPU数量。PyTorch、VLLM、SGLang、Hugging Face等公司或组织将免费获得GPU,这样就能持续集成测试,确保他们研发的软件栈和新功能都能在AMD硬件上开箱即用。

通过频繁的更新、先进的数据类型(如FP4)和新算法(如FAv3),ROCm正在实现下一代AI性能,同时推动开源框架(如vLLM和SGLang)比封闭替代方案更快地向前发展。

ROCm 7将于2025年第三季度普遍可用,支持MI350系列GPU。AMD将在6月12日发布一个公开预览版,官方版本将于8月发布。亮点包括:

1、性能提升:与上一代ROCm 6版本相比,ROCm 7拥有超过3.5倍的推理能力和3倍的训练能力。这源于可用性、性能和对低精度数据类型(如FP4和FP6)支持等方面的进步。通信栈的进一步增强优化了GPU利用率和数据移动。

ROCm的新推理功能

推理方面,与上一代ROCm 6对比,ROCm 7在相同硬件上运行Llama 3.1 70B、Qwen2-72B、DeepSeek R1等模型,可实现3.2~3.8倍的推理和训练性能。

AMD在训练方面同样拥抱开源,有自研的开源模型。AMD组建了一个AI科学家团队,该团队用AMD的软件和硬件来研发模型(包括文本模型、文生图模型、欧洲模型、多模态模型、游戏Agent等),试图实现最佳性能。

新训练功能

这里补充个插曲,欧洲模型源自AMD之前收购的芬兰silo AI。silo AI一直致力于构建支持多种欧洲语言的模型,他们也跟法国明星大模型独角兽Mistral AI合作。

相比ROCm 6,ROCm 7在相同硬件上训练Llama 2 70B、Llama 3.1 8B、Qwen 1.5 7B等开源模型,可实现3~3.1倍的性能提升。

2、分布式推理:ROCm 7引入了一种健壮的分布式推理方法,利用与开源生态系统的协作,包括SGLang、vLLM、llm-d等开源推理框架。通过采用开放策略,ROCm 7与这些合作伙伴一起构建、共同开发共享接口和原语,从而在AMD平台上实现高效的分布式推理。

英伟达TensorRT-LLM工具不支持DeepSeek R1 FP8精度,但vLLM、SGLang等开源推理框架均可支持。由于AMD与这些开源软件紧密合作,MI355X能取得更好的推理结果,吞吐量比B200高出30%。

3、企业AI解决方案:ROCm企业级AI软件栈作为一个全栈MLOps平台首次亮相,专为企业环境中的无缝AI操作而设计,通过交钥匙工具实现安全、可扩展的AI,用于微调、合规性、部署和集成。它包括针对行业特定数据进行模型微调的工具,以及与结构化和非结构化工作流的集成,通过AMD生态系统内的合作伙伴关系来开发参考应用,如聊天机器人和文档摘要。

4、支持在Ryzen笔记本电脑和工作站上的开发:可执行AI辅助代码、定制自动化、先进推理、模型微调等任务,将ROCm体验扩展到端侧。

AMD Ryzen AI 300笔记本电脑可本地运行240亿个参数的AI模型。更专业的Ryzen AI Max笔记本电脑,本地可跑700亿个参数的模型。Threadripper + Radeon AI工作站,本地可跑1280亿个参数的模型。

ROCm将支持In-Box Linux,并首度支持Windows操作系统。预计从2025年下半年开始,ROCm将出现在主要的发行版中,将Windows定位为一流的、得到全面支持的操作系统,确保家庭和企业设置的可移植性和效率。

AMD还首次推出开发者云,让开发者能够即时、无障碍地访问ROCm和AMD GPU,实现无缝的AI开发和部署。

这个完全托管的环境提供了对MI300X GPU的即时访问,无需硬件投资或本地设置,只需Github或电子邮件地址即可轻松设置。Docker容器预装了流行的AI软件,最大限度地减少了安装时间,同时给开发人员定制代码的灵活性。

其可扩展的计算选项包括:

小型,1x MI300X GPU (192GB GPU内存);

大型,8x MI300X GPU (1536GB GPU内存)。

率先注册的开发者可获得25小时的免费积分,通过ROCm Star开发者证书等计划可获得最多50个小时的额外时间。

05.“Helios” AI机架明年问世,搭载下一代3nm AI网卡

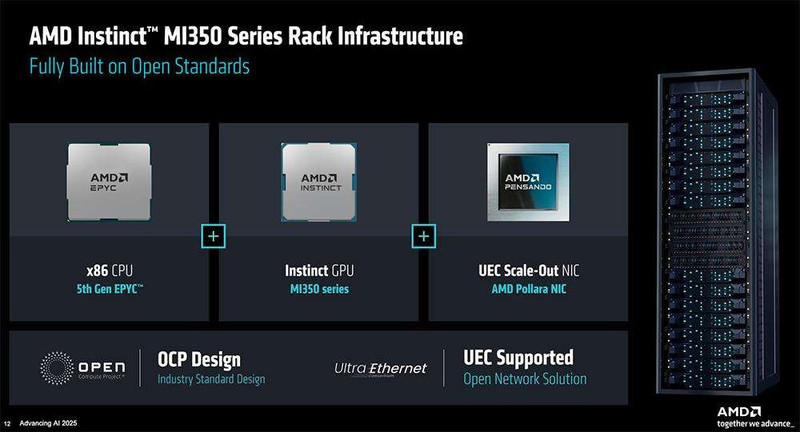

MI350系列机架基础设施完全基于开放标准,可采用x86 CPU(5代EPYC)、Instinct GPU(MI350系列)、UEC Scale-Out NIC(AMD Pensando “Pollara” NIC)。

明年,AMD将推出下一代AI机架基础设施解决方案——Helios AI机架,将集成EPYC “Venice” CPU、MI400系列GPU、Pensando “Vulcano” NIC。

该架构横向扩展基于超以太网(Ultra Ethernet),纵向扩展基于UALink(Ultra Accelerator Link),并提供Fabric Manager作为ROCm生命周期管理的一部分,以支持基础设施自动化。

网络对于构建机架级规模的AI系统至关重要。为了扩大网络规模,AMD去年推出了Pensando Pollara 400 AI NIC。该NIC现可在MI350系统里大规模部署。

相比英伟达ConnectX7、博通Thor2,AMD Pollara可实现高出10%~20%的RDMA性能。

AMD使用UEC标准来推动创新。由于先进UEC功能运行在Pollara内部,AMD可将客户的fabric成本降低16%,这个分析是基于8k GPU集群。当将这些集群扩展到32k、64k、128k时,成本和节省幅度会快速增加。

作为MI400系列的一部分,下一代AMD Pensando “Vulcano” AI NIC将在2026年作为默认配置发货。

Vulcano采用3nm制程,提供800G网络吞吐量,每GPU的横向扩展带宽是上一代的8倍,支持UAL和PCIe Gen6,相比PCIe Gen6提供了2倍的带宽,可扩展到100万块GPU,并具有完整的软件向前和向后兼容。

这些优势将直接转化为更快的模型训练和更好的推理性能,为客户带来巨大的经济优势。

06.AI网络:UALink支持1024块GPU互连,今年Q3推出全新DPU

AI模型尺寸每三年增长1000倍,不仅需要更多的计算、内存,还需要更多的网络带宽来进行训练和分布式推理。如今训练数据集每8个月翻一番。这些需求都超过了芯片的发展速度,芯片晶体管密度每两年才翻一番。

唯一的方法是构建分布式系统创新,实现AI芯片的数据中心级扩展。

为了支持大量GPU一起工作,AMD与100多家公司一起成立了超以太网联盟(Ultra Ethernet)。超以太网技术是以太网的进化,能扩展至英伟达Infiniband的20倍、经典以太网的10倍。

去年成立的UALink(Ultra Accelerator Link)联盟旨在扩展将AI芯片网络规模,提供更高的带宽、更低的延时。与英伟达NVLink相比,UALink完全开放,由100多个联盟成员支持,意味着客户可以使用任何GPU、任何CPU和任何交换机来扩展他们的架构。

UALink支持多达1024个GPU连接在一起的能力,是英伟达NVLink支持GPU规模的2倍。

在GPU系统连接的前端网络方面,AMD宣布Salina 400 DPU将在今年第三季度推出,目标成为“目前市场上性能最好、最安全、可扩展的AI前端网络基础设施”。

Salina 400 DPU的性能达到上一代的2倍,相比英伟达Bluefield 3 DPU性能提升40%。该DPU可安全桥接AI服务器到企业,提高AI服务器性能与网络、安全性、存储卸载,引擎对网络功能的加速可达到CPU的40倍。

自动化同样不可或缺。ROCmAI生命周期管理软件,可将客户的部署时间从几个月减少到几天。

ROCm将在2026年推出Fabric Manager,确保用户可自动部署机架级规模的应用,并自带可靠性、可用性和可维护性。

07.AMD设定2030年新目标:将机架级能效提高20倍

能效长期是与AMD的路线图和产品战略相一致的指导核心设计原则。

在2020年,AMD通过在短短六年内将AMD移动处理器的能效提高25倍,超额完成了25x20的目标。

如今AMD已超越其30x25的目标(与2020年相比,将加速计算节点的能源效率提高30倍),在AI训练和高性能计算方面,使用当前配置的4个MI355X GPU和一个EPYC第五代CPU,实现了38倍的节点级能效提升,与5年前的系统相比,在相同的性能下,能耗降低了97%。

现在,AMD又设定了一个新的2030年目标,即在2024年的基础上,将机架规模的能源效率提高20倍(几乎是之前行业效率的3倍),使目前需要超过275个机架的典型AI模型到2030年能够在一个机架内进行训练,同时减少95%的运营用电量,将模型训练的碳排放量从约3000公吨减少到100公吨。

这些预测是基于AMD芯片和系统设计路线图以及经能效专家Jonathan Koomey博士验证的测量方法。

结合软件和算法的进步,新目标可以使整体能源效率提高100倍。

到2030年机架规模的20x目标反映了下一个前沿领域:不仅关注芯片,还关注更智能、更高效的系统,从芯片到全机架集成,以满足数据中心级的功率需求。

08.结语:全栈布局,豪赌AI计算未来

AI基础设施如今已是数据中心AI芯片兵家必争之地。从今日释放信息来看,AMD面向整个机架级基础设施的布局已趋于完整,覆盖从CPU、GPU、内存、网络、存储、软硬件协同设计到系统的性能与能效优化。

随着顶尖大模型性能增长放缓,产学界不再一味炼大模型,而是更多探索围绕可持续、更经济地扩展AI计算的相关创新,这正推动AI模型的训练和部署效率持续提升。

除了提升硬件性能与配置外,AI软件栈和AI机架级基础设施的优化,都成为AMD面向未来增强AI竞争力的重点投入方向。与英伟达不同的是,AMD认定开源才能推动AI以最快速度进步,正坚定拥抱开源,构建一个完全开放的软件生态系统。

在演讲尾声,苏姿丰博士强调:“AI的未来不会由任何一家公司或在一个封闭的生态系统中建立,它将由整个行业的开放合作来塑造成型。”

作为全球数据中心AI芯片市场的第二名,AMD比第一名的包袱更轻,比后位者吞食市场份额的机会更大。而蓄势待出的MI400系列和“Helios” AI机架级基础设施,将蕴藏着AMD押注下一股AI浪潮、释放生成式AI和高性能计算的机遇与潜力。

文章来自于微信公众号“智东西”,作者是“ZeR0”。