2022年,预言家放言:到2025年,押注90%的概率AI拿不下国际奥数IMO金牌。

可谓言之凿凿,信心十足。

然而仅仅两年,OpenAI与谷歌DeepMind双双击碎了悲观预言:

LLM不仅提前「封神」摘金,还打破了对AI能力边界的想象。

从语言生成到逻辑推理,从通用能力到专业领域竞技,生成式AI正以惊人的速度越过每一道人类设下的「智力高墙」。

预测错得越离谱,AI给人的感觉就越震撼。

如今,几乎可以确定,AI发展速度远超过去几年的主流预期。

巨变,才刚刚开始。

预言家集体翻车

刚刚,宾大沃顿商学院教授、生成式人工智能实验室联合主任Ethan Mollick非常笃定:过去,人们低估了AI发展的速度。

他举了一个例子:

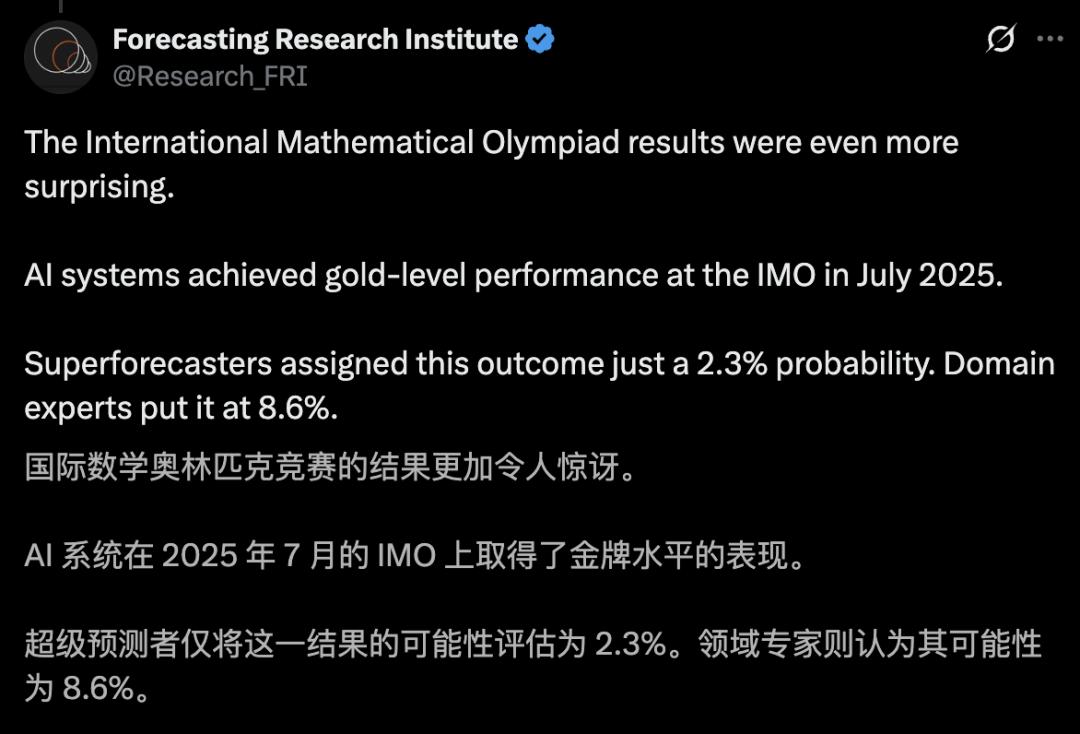

2022年,预测研究院(Forecasting Research Institute)邀请169名顶尖预测专家和学者评估AI进展。

当时,他们分别给出结论:到2025年,仅有2.3%和8.6%概率,AI能赢得国际数学奥林匹克金牌。

结果,被现实啪啪打脸:谷歌DeepMind的Gemini、OpenAI的ChatGPT,这两个通用大模型拿下了2025年国际数学奥赛的金牌。

谷歌DeepMind和OpenAI争夺AI史上第一块「IMO金牌」:OpenAI抢先发布了自家结果,但谷歌DeepMind的模型成绩获得了IMO官方认证。

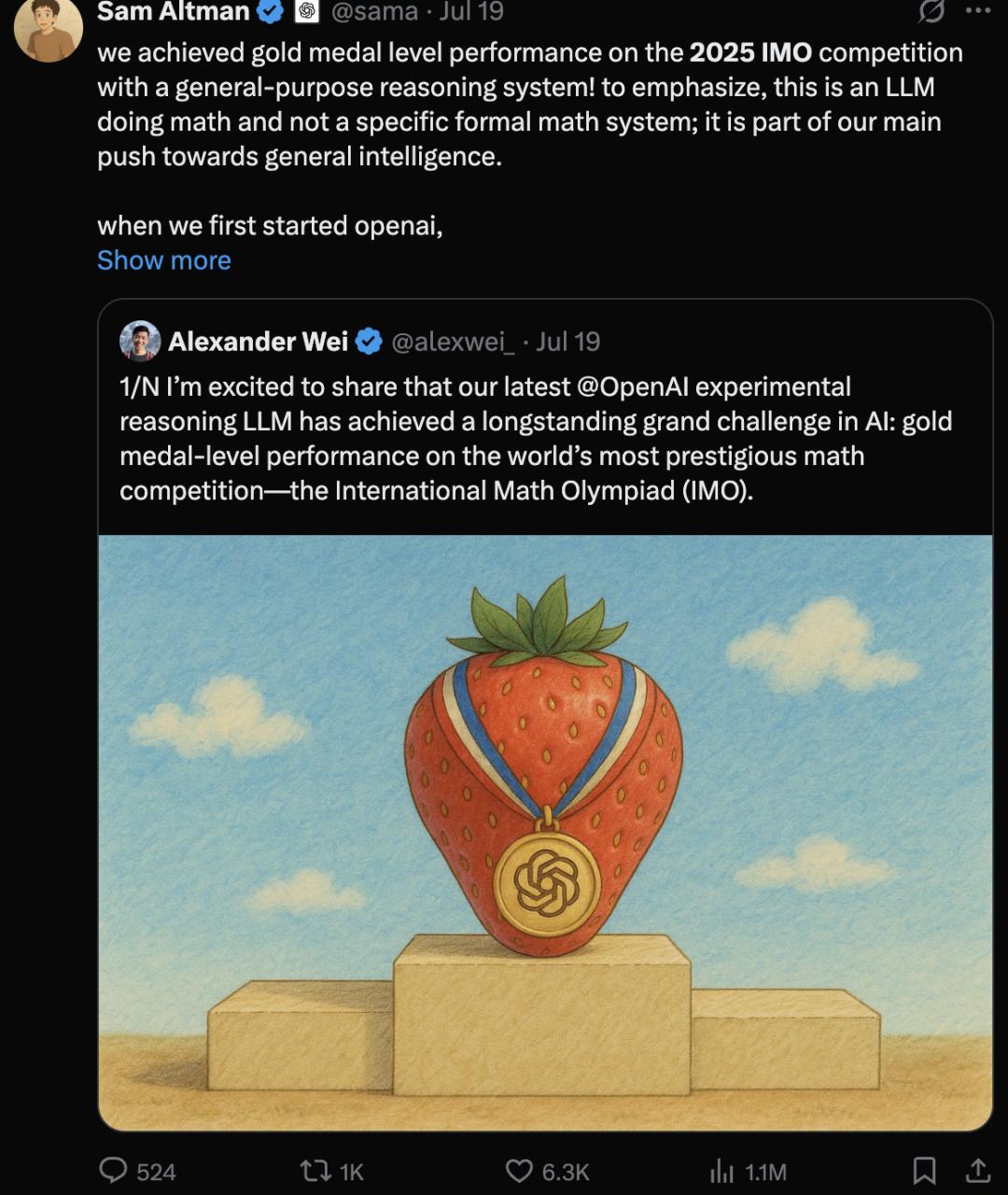

OpenAI先声夺人,集体造势,收获了一大波流量:

据称,为了尊重参赛学生,谷歌等到IMO官方认证成绩后才公布了结果。

这是一个AI的历史性时刻,标志着过去十年AI的巨大进步。

大语言模型,本为生成语言而生,但在数学上也远超大部分人的想象。

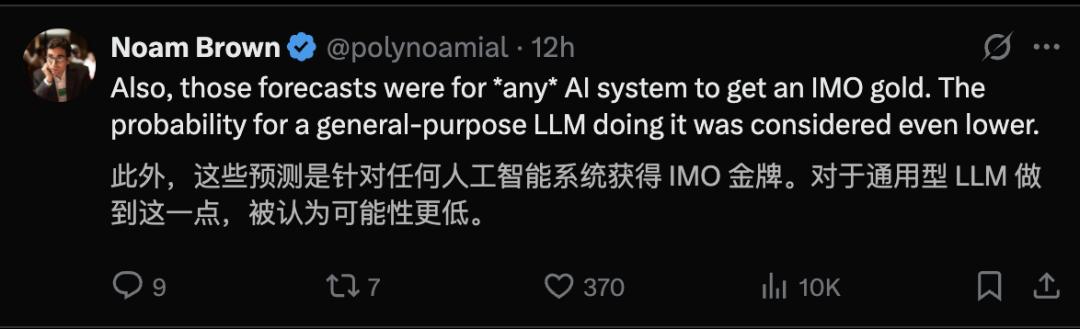

OpenAI的研究科学家Noam Broen认为,当时的预测对LLM更悲观:

而且需要注意的是,这些预测说的「任何」一种AI系统能夺得奥赛金牌。如果换成是「大语言模型」这类通用AI系统,他们眼中的概率更低。

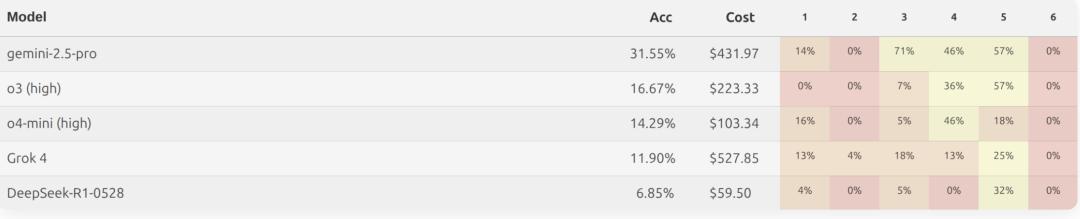

而且就在国际奥数成绩发布前,MathArena测评了当时的可用的大模型,没一个能拿到铜牌:

之后,不久传来了AI获得金牌的消息。

在数学推理上,LLM一再被低估。

预测研究院承认:AI在国际奥数竞赛上,成绩惊艳。

预测失准,不是偶然,是范式变了。

事实上,在MATH、MMLU和QuALITY三个标准的AI基准测试,预测几乎全军覆没。

在MATH数据集基准测试,GPT-4 Turbo在2024年4月达到了87.82%,而领域专家和超级预测者认为截至2024年6月30日,达到这一水平的概率为21.4%和9.3%。

在MMLU上,GPT-4o和Claude 3.5 Sonnet在2024年年中达到了88.7%,而预测的可能性只有25.0%和7.2%。

在QuALITY Hard子集上,RAPTOR + GPT-4在2023年6月得分为69.3——比截止日期早整整一年。

无论是领域专家还是超级预测者,都错误判断了AI发展的速度和方向。

两组人群都低估了截至2024年底AI的最大算力,其中超级预测者的预测值只有实际最大值的1/5。与此同时,他们又高估了机器学习模型的上限:

专家预测参数规模将达到1.00E+14(100万亿),

超级预测者则给出4.00E+14(400万亿)的预期,

均比当前初步确认的1.00E+13(10万亿)参数规模高出十倍。

与此类似,麦肯锡发布过一份报告,展示了人工智能专家小组在2017年(在LLMs之前)的预测。

例如,麦肯锡预测AI将在2037年达到人类平均创造力水平。但实际上,在2023年这一目标已经实现。

而对于达到前1/4创造力水平的预测,麦肯锡原本估计要到2055年,但这一目标也已经提前30年达成。

由于生成式人工智能的发展,技术性能预计将比之前估计的更快地达到与人类中位数水平相当的性能,并在广泛的能力范围内达到人类前25%的顶尖水平

再例如,麦肯锡全球研究院(MGI)之前认为,在自然语言理解方面,技术最早可能在2027年达到与人类中位数相当的水平,但在新的分析中,这一时间点已提前到2023年。

在2025年的报告中,麦肯锡表示在过去的两年里,人工智能取得了飞速发展,许多重要的AI创新涌现⬇️。

现实中AI进步如此神速,网友Aravind Sunda惊叹:

变化之快堪称疯狂。2022年看似不可能的事,现在已触手可及。

2022年11月30日,ChatGPT正式公布。而之前,生成模型或GenAI更多指图像、视频等生成模型,OpenAI还在探索GPT的应用场景。

所以,ChatGPT有可能才是最大的变量,正如网友Mahaoo所言:

在ChatGPT和GPT-4问世之前的所有预测,几乎都注定严重低估了AI的实际进展。因为这些模型的横空出世,让外界第一次真正看清了AI的潜力和速度。

不过,LLM存在锯齿型智能现象:在某一方面表现出色,另一方面一塌糊涂。

威斯康星大学计算机科学教授Pedro Domingos就质疑了这种概括性结论:

AI在某些领域确实领先,但在其他领域则不然。基于预测家考虑的少数领域,很难做出这样一概而论的判断。

或许,人们常常高估AI短期的发展,而总是低估它的长期进步。

而一个更大的转变正在酝酿:我们正进入「大众智能」时代,强AI变得像谷歌搜索一样容易获取。

群体智能时代

对于大多数用户来说,访问强AI一直有两个障碍

1. 困惑:很少有人知道该怎么选AI模型。

2. 成本:顶级模型很贵,免费用户往往用不了,或者只有非常有限的访问权限。

而GPT-5本计划解决这两个问题:利用路由机制,避免简单问题浪费算力,自动选择模型,从而让更多人有机会使用推理模型等强AI。

这套机制在上线初期解释不足,路由判断也经常失灵,看起来乱七八糟、让人困惑。尽管如此,奥特曼很快宣布GPT-5取得了初步成功:

上线几天内,经常使用推理模型的付费用户比例从7%升至24%,而免费用户中能接触到顶尖模型的比例也从几乎为零提高到了7%。

推动这一切变化的,还有模型效率的飞跃。

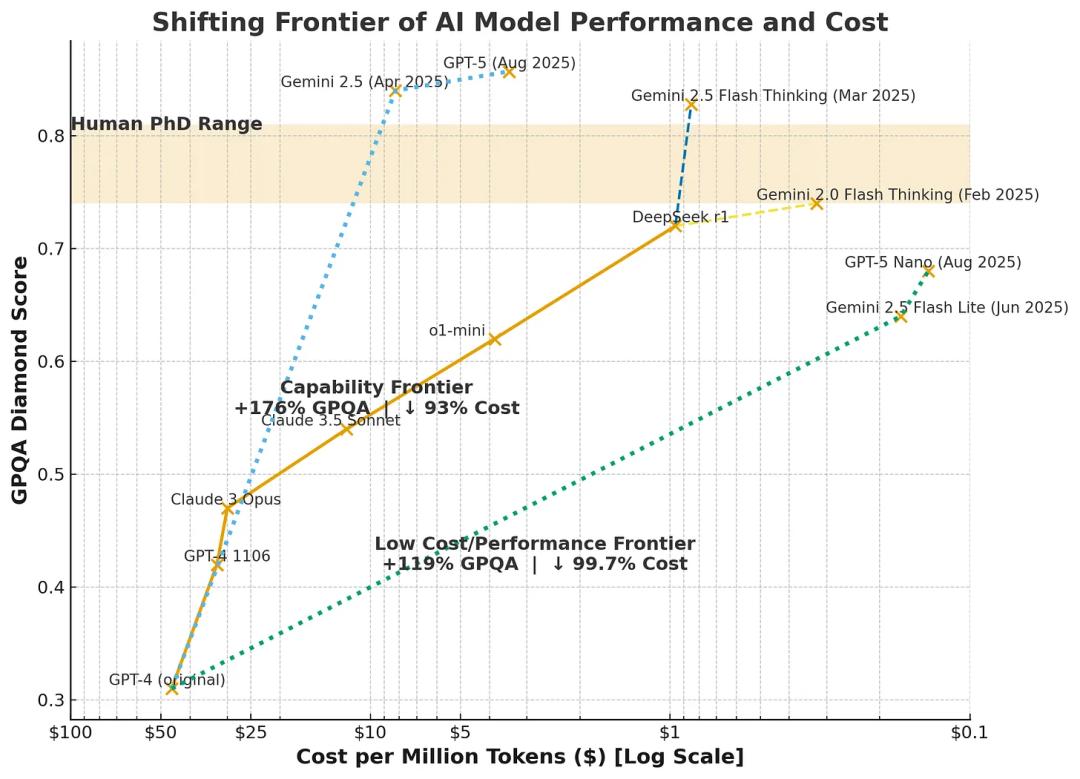

AI变得越来越聪明,但运行成本却急剧下降。下图直观展示了这一趋势。

这些改进带来的直接后果就是:哪怕AI越来越强大,它也变得足够便宜,可以普惠大众。

服务新增用户的边际成本,几乎崩塌式下降。这也让广告等商业模式成为可能。

两年前要花上几美元的提示任务,如今免费用户就能轻松运行。

这就是十亿人突然拥有强大AI的真正原因:并不是因为某个宏大的「平民化AI」愿景,而是因为算力经济学终于走到这一步。

不过,光能用上强AI还不够,关键是人们要能真正用它来完成任务。

过去,高效使用AI是「黑科技」魔法:

要靠精心编写提示词,

利用思维链(chain-of-thought)等技巧,

再配合各种小窍门,才能逼近理想答案。

但最近的一系列实验表明,这些技巧已经不再重要。

传送门:

https://gail.wharton.upenn.edu/research-and-insights/tech-report-chain-of-thought/

如今的顶尖模型越来越擅长直接理解并完成请求,甚至能「揣摩」用户的真实意图,自动超出预期去完成任务。

而且,变化不仅发生在文本模型上。

最近,谷歌发布了一款全新的图像模型,内部代号「nano banana」。

它不仅在图像编辑上表现出色(甚至比生成全新画面还更稳定),而且便宜到足以开放给免费用户使用。

更关键的是,它终于能很好地理解自然语言指令,省去了复杂的「提示词工程」。

当数亿人掌握强AI,各种现象会同时发生。事实上,它们已经在发生了:

有人与AI模型建立了深厚的情感关系,也有人借此摆脱孤独;

有人因为AI而走向精神崩溃或危险行为,也有人利用AI诊断疾病、挽救生命

……

衍生出了数以千计的意想不到的用途。

随着模型愈发强大,这些应用场景、问题与益处只会成倍增长。

AI巨头——无论你是否相信它们关于「安全」的承诺——根本无法完全消化这股浪潮。

当十亿人同时拥有先进AI时,人类真正进入了所谓的群体智能时代。

我们所有的制度——学校、医院、法庭、公司、政府——过去都建立在「智能稀缺而昂贵」的前提之上。

如今,每一个职业、每一家机构、每一个社区,都必须重新思考:

如何在群体智能的环境中生存与繁荣?

如何在全民造假的世界里重建信任?

如何在普及知识的同时,保留人类专业经验的价值?

参考资料:

https://x.com/emollick/status/1962859757674344823

https://www.mckinsey.com/~/media/mckinsey/business functions/mckinsey digital/our insights/the economic potential of generative ai the next productivity frontier/the-economic-potential-of-generative-ai-the-next-productivity-frontier.pdf

https://www.oneusefulthing.org/p/mass-intelligence

本文来自微信公众号“新智元”,作者:新智元,编辑:KingHZ,36氪经授权发布。